Een groeiende uitdaging bij de opslag van AI-gegevens

Kunstmatige intelligentie zorgt voor doorbraken in verschillende sectoren en zorgt voor een revolutie op het gebied van onder meer medische diagnostiek, financiële modellen, zelfrijdende voertuigen en grootschalige automatisering. Maar naarmate AI-systemen steeds geavanceerder worden, nemen de eisen aan gegevensopslag exponentieel toe. Dit brengt uitdagingen op het gebied van schaalbaarheid, efficiëntie en kosten met zich mee.

Voor datasets voor machinaal leren zijn tegenwoordig petabytes aan opslagruimte nodig. Sommige ondernemingen beheren zelfs exabytes aan datasets om gelijke tred te houden met de ontwikkelingen op het gebied van AI-modellen. Deze enorme datasets moeten efficiënt opgeslagen, opgehaald en verwerkt worden om modeltraining en inferentie te ondersteunen. De opslaginfrastructuur achter AI is niet langer alleen een kwestie op het gebied van IT, maar is een belangrijke factor voor AI-innovatie geworden.

Ondanks de vooruitgang op het gebied van AI-computing zijn traditionele opslagarchitecturen complex en duur geworden op de schaal die nodig is om dataverslindende GPU's te voeden. Dit introduceert beperkingen die de acceptatie van AI vertragen. Hiervoor zijn drie redenen:

Ten eerste leveren SSD-gebaseerde architecturen weliswaar hoge snelheden, maar vanwege de hoge aanschafkosten zijn ze onpraktisch voor de grootschalige opslagbehoeften van AI-trainingswerkbelastingen. Voor de meeste bedrijven is het financieel niet haalbaar om grote datasets uitsluitend op SSD's te bewaren.

Ten tweede bieden SAS/SATA harde schijfsystemen nog steeds betrouwbare en kosteneffectieve opslag voor veel bedrijfstoepassingen. AI-werkbelastingen stellen echter unieke eisen aan de opslaginfrastructuur. SAS/SATA-interfaces zijn afhankelijk van bedrijfseigen silicium, hostbusadapters (HBA's) en controllerarchitecturen die oorspronkelijk niet zijn ontworpen voor de hoge doorvoer met lage latentiebehoeften van AI-werkbelastingen. Naarmate de acceptatie van AI toeneemt, kunnen deze factoren complexiteit en extra latentie met zich meebrengen, waardoor het voor AI-modellen moeilijker wordt om snel toegang te krijgen tot grote datasets.

Tot slot gaan AI-werkbelastingen die afhankelijk zijn van cloud-gebaseerde opslag vaak gepaard met hoge WAN-kosten voor gegevensoverdracht, latentiepieken en onvoorspelbare ophaaltijden. Deze inefficiënties beperken de responsiviteit van AI-modellen en verhogen de bedrijfskosten, omdat de verwerkingshardware moet wachten op externe gegevens.

Naarmate AI verder opschaalt, is er daarom een nieuwe aanpak nodig: een aanpak die bestaande opslagarchitecturen aanvult en tegelijkertijd de balans vindt tussen capaciteit, kosten en snelheid om AI-training en -inferentie te ondersteunen zonder compromissen.

Een nieuwe aanpak: NVMe harde schijven voor AI-werkbelastingen

Seagate levert een baanbrekende oplossing door NVMe-technologie naar harde schijven met een hoge capaciteit te brengen. Door NVMe te ontwikkelen als een toekomstig standaardprotocol voor de connectiviteit van harde schijven, biedt Seagate een alternatief dat is ontworpen om AI-datapijplijnen te optimaliseren, knelpunten in de opslag te verminderen en tegelijkertijd de voordelen van harde schijven op het gebied van betaalbaarheid en opslagdichtheid te behouden.

In tegenstelling tot harde schijven die op SAS/SATA zijn gebaseerd, zijn er bij NVMe harde schijven geen HBA's, protocolbruggen en extra SAS-schijven nodig, waardoor AI-opslag beter gestroomlijnd is. Met deze schijven kunnen AI-werkbelastingen naadloos worden geschaald door de integratie van opslag op harde schijven met hoge dichtheid en supersnelle SSD-caching in een uniforme NVMe-architectuur.

Dit zal aanzienlijke voordelen opleveren. Ten eerste vereenvoudigen NVMe-harde schijven de implementatie van AI-opslag doordat er geen hardwareadapters meer nodig zijn voor de interface met de processor. Hierdoor kunnen organisaties grootschalige AI-opslagomgevingen bouwen zonder gespecialiseerde controllers. Ten tweede zorgen deze schijven ervoor dat harde schijven en SSD's efficiënt samenwerken dankzij een enkele NVMe-driver en OS-stack, waardoor er geen aparte softwarelagen meer nodig zijn.

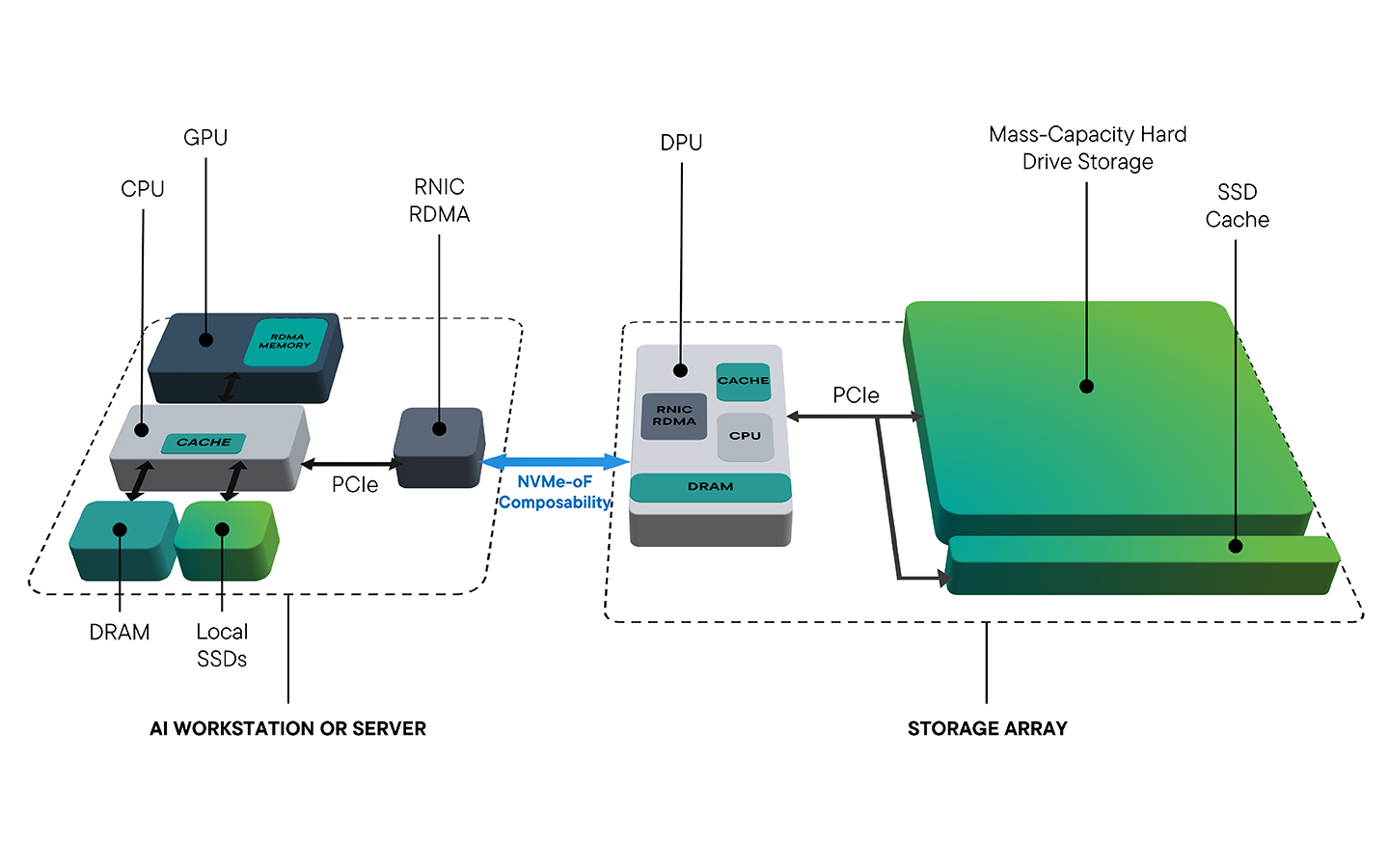

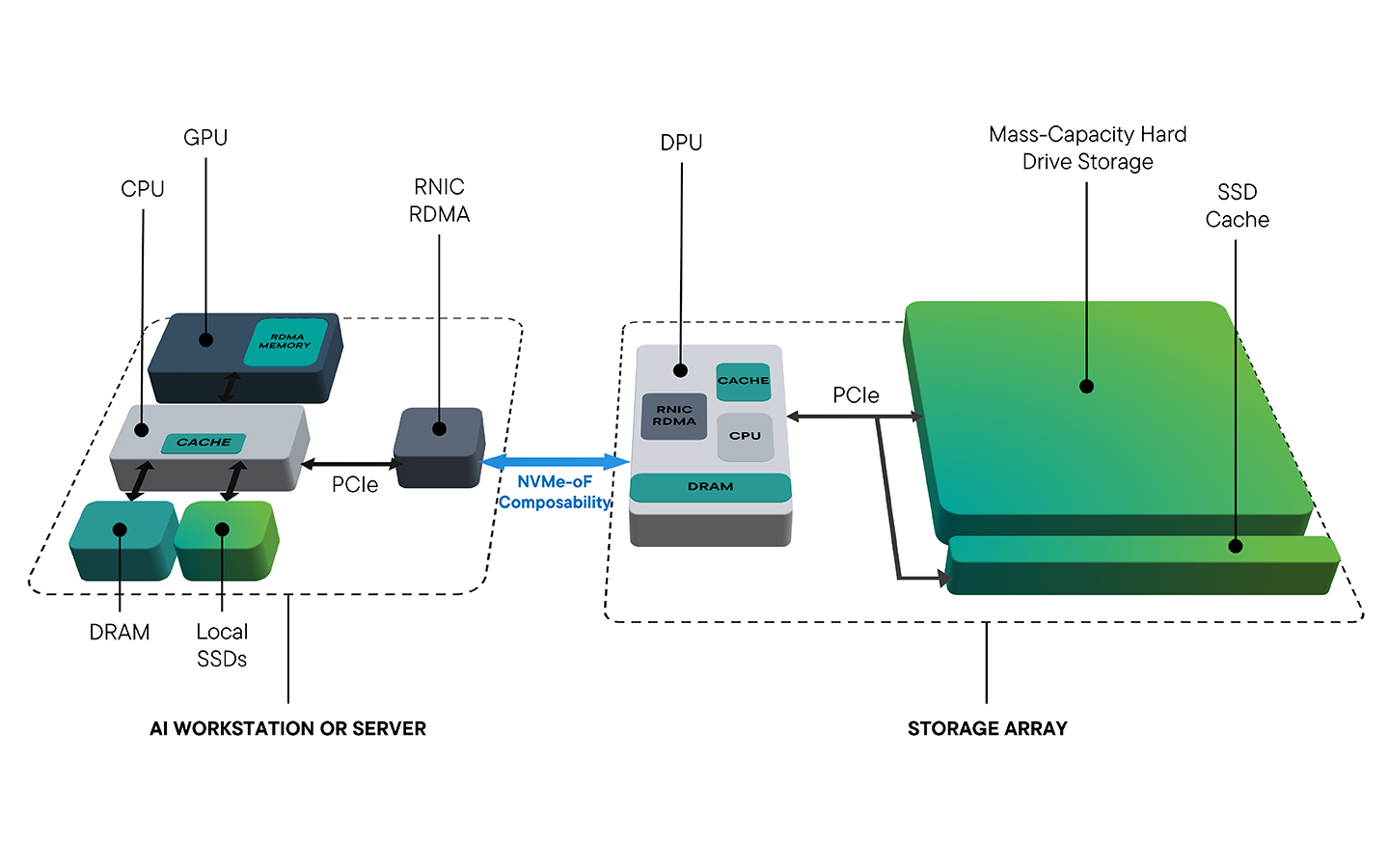

Een van de belangrijkste voordelen is de directe gegevenstoegang van GPU naar opslag via DPU's, waardoor CPU-bottlenecks worden omzeild. Traditionele opslagarchitecturen sturen gegevens door CPU-gestuurde pijplijnen, waardoor latentieproblemen ontstaan. NVMe harde schijven kunnen deze inefficiëntie elimineren, waardoor AI-modellen enorme datasets kunnen opnemen en verwerken met aanzienlijk minder vertraging.

Bovendien kunnen NVMe-oF harde schijven (NVMe over Fabrics) met NVMe integreren in gedistribueerde AI-opslagarchitecturen, waardoor naadloos schalen binnen netwerken van datacenters met hoge prestaties mogelijk wordt. Deze functie is vooral handig voor ondernemingen die flexibele, samenstelbare opslagoplossingen voor AI-workflows nodig hebben.

Door NVMe harde schijven samen met SSD's te gebruiken, kunnen organisaties de kosten optimaliseren en tegelijkertijd de prestaties behouden. Ze kunnen SSD's reserveren voor actieve datasets en harde schijven gebruiken voor de langetermijnbewaring van AI-trainingsgegevens.

Bewijs voor de toekomst: Seagate's proof of concept voor NVMe harde schijven

Om de potentiële impact van NVMe harde schijven in de echte wereld aan te tonen, voerde Seagate een proof of concept (POC) uit waarin NVMe harde schijven, NVMe SSD's, NVIDIA BlueField DPU's en AIStore software werden geïntegreerd en een zeer efficiënt AI-opslagecosysteem werd gedemonstreerd.

Dit POC benadrukte de belangrijkste voordelen van NVMe harde schijven in AI-workflows en leverde het bewijs dat ze een aanzienlijke impact kunnen hebben in grootschalige AI-opslagomgevingen:

- De technici hebben aangetoond dat directe communicatie tussen GPU en opslag via NVMe-harde schijven en DPU's helpt de opslaggerelateerde latentie in AI-dataworkflows te verminderen.

- Legacy SAS/SATA-overhead werd geëlimineerd, waardoor de systeemarchitectuur werd vereenvoudigd en de opslagefficiëntie werd verbeterd.

- AIStore heeft caching en tiering dynamisch geoptimaliseerd, waardoor de trainingsprestaties van modellen worden verbeterd terwijl opslagaggregatie en schaalbaarheid tot exabyteniveaus worden vereenvoudigd.

- NVMe-oF-integratie maakte naadloze schaalbaarheid mogelijk en bewees de samenstelbaarheid van AI-opslagclusters met meerdere racks..

Met dit POC laat Seagate zien hoe NVMe harde schijven 's werelds meest veeleisende AI-werkbelastingen kunnen ondersteunen zonder dat daarvoor all-flash architecturen nodig zijn.

Effecten in de echte wereld: AI-opslag in actie

Seagate maakt gebruik van zijn decennialange ervaring met het implementeren van AI-modellen in zijn slimme fabrieken om NVMe-harde schijven te valideren in echte AI-werkbelastingen.

In de kwantumantenneproductiefaciliteiten van Seagate is AI-gestuurde defectdetectie afhankelijk van snelle beeldopname en snel ophalen voor modeltraining en continue verbetering. Door inzichten uit zijn eigen AI-gestuurde productieomgevingen toe te passen, onderzoekt Seagate hoe NVMe-harde schijven dit proces mogelijk zouden maken door schaalbare, kosteneffectieve opslag te bieden die zowel realtimeverwerking als langetermijnretentie ondersteunt:

- Massacapaciteit voor het opslaan van high-definition beelden zonder gegevenscompressie met verlies.

- Efficiënte langetermijnopslag van AI-trainingsdatasets.

- Naadloze toegang voor AI-modelhertraining en continue verbeteringen.

Door de integratie van NVMe harde schijven in een opslagarchitectuur te onderzoeken, laat Seagate zien hoe de nieuwe technologie de opslagkosten voor AI zou verlagen en tegelijkertijd zou zorgen voor realtime reactiesnelheid voor AI-defectdetectie. De efficiëntiewinst omvat snellere AI-gestuurde analyses, verbeterde nauwkeurigheid en lagere infrastructuurkosten.

Naast productie kunnen NVMe harde schijven gebruikt worden in autonome voertuigen, beeldvorming in de gezondheidszorg, financiële analyses en hyperscale cloud-AI-platforms.

Duurzaamheid en kostenbesparingen: Voordelen van NVMe harde schijven

AI-infrastructuur verbruikt enorme hoeveelheden stroom, waardoor duurzaamheid een steeds groter probleem wordt. Het werk van Seagate op het gebied van NVMe harde schijven verkent een kosteneffectief en energiezuinig alternatief voor SSD-intensieve architecturen.

Vergeleken met SSD's bieden NVMe harde schijven:

- 10× efficiëntere ingebedde koolstof per terabyte, waardoor de impact op het milieu aanzienlijk wordt verminderd.

- 4× efficiënter verbruik van bedrijfsstroom per terabyte, waardoor de energiekosten van AI-datacenters dalen.

- Aanzienlijk lagere kosten per terabyte, waardoor de TCO van AI-opslag op schaal wordt verlaagd.

Naarmate de AI-infrastructuur verder groeit, wordt duurzame opslag een cruciale factor om zowel de kosten als de impact op het milieu te verminderen. Het stappenplan van Seagate omvat voortdurende verbeteringen in de efficiëntie van NVMe harde schijven, met als doel organisaties te helpen bij het schalen van AI-opslag en tegelijkertijd te voldoen aan duurzaamheidsdoelen op de lange termijn.

Een stappenplan voor de toekomst van AI-opslag

Seagate ontwikkelt innovaties die de volgende generatie AI-geschikte opslaginfrastructuur mogelijk maken, in lijn met trends in de sector en de behoeften van hyperscale- en cloudomgevingen.

Het stappenplan omvat:

- Het opschalen van het Mozaic-platform (dat nu schijven van 36 TB levert) om NVMe harde schijven met een nog hogere capaciteit te ontwikkelen.

- Geavanceerde NVMe-oF-ondersteuning, waardoor AI-werkbelastingen naadloos kunnen schalen in hybride omgevingen.

- Het creëren van referentiearchitecturen, zodat AI-ontwikkelaars geoptimaliseerde opslagoplossingen gemakkelijk kunnen implementeren.

Seagate werkt samen met klanten en partners om te onderzoeken hoe NVMe-harde schijven kunnen worden ingezet in AI-opslagoplossingen van de volgende generatie, zodat ondernemingen op een betaalbare en efficiënte manier kunnen voldoen aan de vraag naar AI-opslag.

Seagate's toewijding aan de toekomst van AI-opslag

AI transformeert industrieën, maar toch worstelen veel organisaties met de complexiteit van gegevensbeheer en de stijgende opslagkosten. Schaalbare, efficiënte opslag is essentieel om AI-innovatie vooruit te helpen.

Het werk van Seagate op het gebied van NVMe harde schijven laat zien hoe NVMe-connectiviteit de complexiteit van de opslagimplementatie kan verminderen en tegelijkertijd de kosten- en dichtheidsvoordelen van harde schijven kan behouden.

Door AIStore-integratie, NVMe-oF-schaalbaarheid en GPU-geoptimaliseerde opslagpaden in de POC mogelijk te maken, loopt Seagate voorop in de volgende golf van innovatie op het gebied van AI-infrastructuur.

Terwijl AI de industrie verandert, definieert Seagate opnieuw hoe AI-opslaginfrastructuur kan worden geschaald om te voldoen aan de toenemende vraag naar gegevensopslag.