人工智能 (AI) 和机器学习 (ML) 推动了变革性突破,从预测蛋白质结构到实现实时语言翻译等。这些创新的核心是对高质量数据的无限需求。AI 模型在庞大的数据集上蓬勃发展,但如果没有可靠且经济高效的数据存储,这些模型及其生成的洞察将无法发挥其潜力。

正如氧气维持人类生命,数据存储支撑着 AI 的发展。高效存储、访问及处理数据的能力决定了 AI 模型的训练和优化效率。然而,随着对 AI 驱动型解决方案需求的增长,管理 AI 数据生命周期(从收集、存储到处理)相关的挑战也在增加,同时还要控制成本和复杂性。

对 AI 就绪型数据不断增长的需求

数据科学已经从电子表格和简单分析发展成为由机器学习驱动的强大洞察。根据美国劳工部的数据,目前有超过 200,000 个数据科学工作岗位,预计在未来十年将增长 36%。各行各业的领域专家正在将 AI 工具融入他们的工作流程中,即便没有接受过正式的数据科学培训,也能借助无代码平台以前所未有的速度构建模型、分析数据。

但原始数据本身并无用处。在将数据输入 AI 模型之前,必须对数据进行结构化、清理和标记处理,这个过程通常称为数据整理。开源工具例,如Pandas,有助于将海量数据集转换为 AI 模型可以使用的结构化格式。但是这个过程需要快速、高效的本地数据存储,才能避免减缓模型开发的瓶颈。

AI 数据管理方面的挑战

AI 训练数据的庞大体量带来了巨大的运维挑战。存储和管理大型数据集不仅仅关乎容量,还关乎成本、合规性和可访问性。

AI 数据管理的一些重大挑战包括:

- 数据主权和安全性。组织必须遵守有关知识产权、隐私和司法控制的法规。

- 云存储成本。与使用本地 NAS 解决方案相比,将 AI 数据集存储在云中的成本可能高达 5 倍,甚至是 10 倍。

- 数据移动瓶颈。跨广域网传输大型数据集速度慢且成本高,这会对地理上分散各地的团队造成延迟。

传统的集中式存储方法受到地理位置分散的数据源所带来的挑战。越来越多的 AI 从业者正在转向本地化的边缘存储解决方案,以实现更好的控制、更低的成本和更少的延迟。

将 AI 数据存储引入边缘

组织可以在更接近数据生成的位置处理和存储 AI 数据,而不是将大量数据集传输到集中式云服务器。这种方法通常称为边缘计算,可在提高性能的同时最大限度地减少数据移动成本。

一种经济高效的解决方案是小型混合 NAS 系统,可为 AI 工作负载提供本地高性能存储。与传统 NAS 不同,这些系统集成了 Jupyter Notebook 等容器化 AI 工具,助力领域专家和 AI 开发人员直接基于存储系统本身进行协作。通过消除对持续数据传输的需求,这些 NAS 解决方案降低了运营成本,同时加速了 AI 开发。

在边缘处理 AI 数据还可以让组织更好地控制其数据集。维护对 AI 训练数据的自主权,确保符合行业法规,并降低与第三方存储相关的风险。借助这种方法,将数据保存在收集和分析的位置,使得 AI 工作流更加高效。

边缘计算为 AI 开发提供多种优势:

- 降低成本:减少云存储和数据传输费用。

- 更快的 AI 开发速度。将训练数据保存在本地以实现快速访问。

- 更好的数据控制。通过确保在内部存储和处理数据,维护数据主权和合规性。

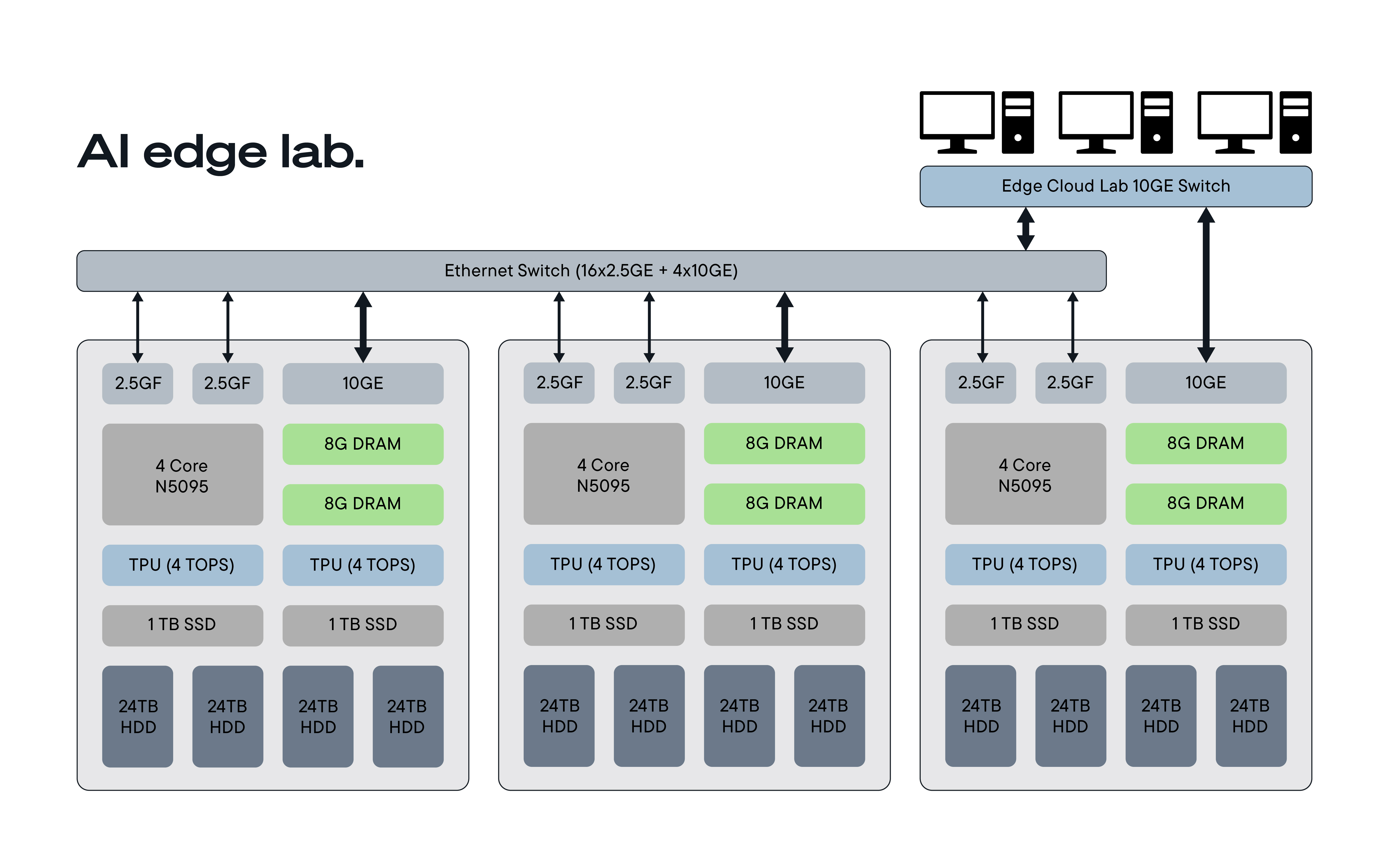

AI 边缘实验室:系统架构和设置

为了探索在本地化存储上运行 AI 工作负载的可行性,我们构建了一个三节点 NAS 集群,并对其存储性能进行了评估。

系统配置:

- 硬件:

- Intel N5095 处理器(低功耗使用场景)

- 双 2.5GE 以太网端口

- 4 x 24TB IronWolf® Pro 硬盘(RAID5,每个节点可用容量 70TB)

- 固态硬盘 (SSD)(可选)和张量处理单元 (TPU),以实现加速

- 软件:

- Jupyter Notebook 容器,用于基于 Python 的 AI 开发

- NATS Jetstream,用于容错消息传递、键值存储和对象存储

- 多节点数据复制,实现冗余和弹性

性能测试:评估存储和网络

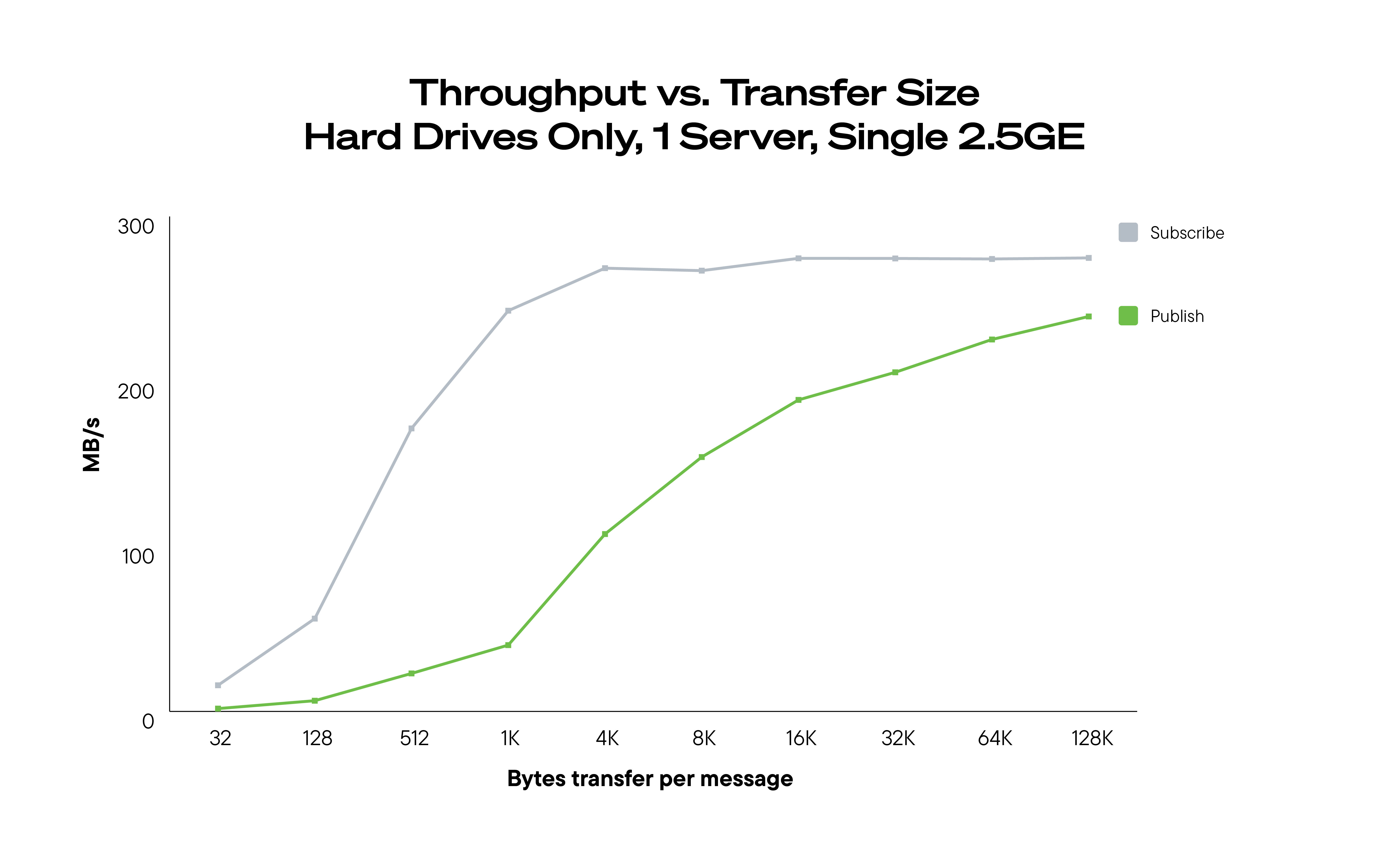

我们首先评估了单节点性能,以确定吞吐量基准。对于大型数据传输,该系统在每 2.5GE 链路上实现了 200MB/秒的传输速度。

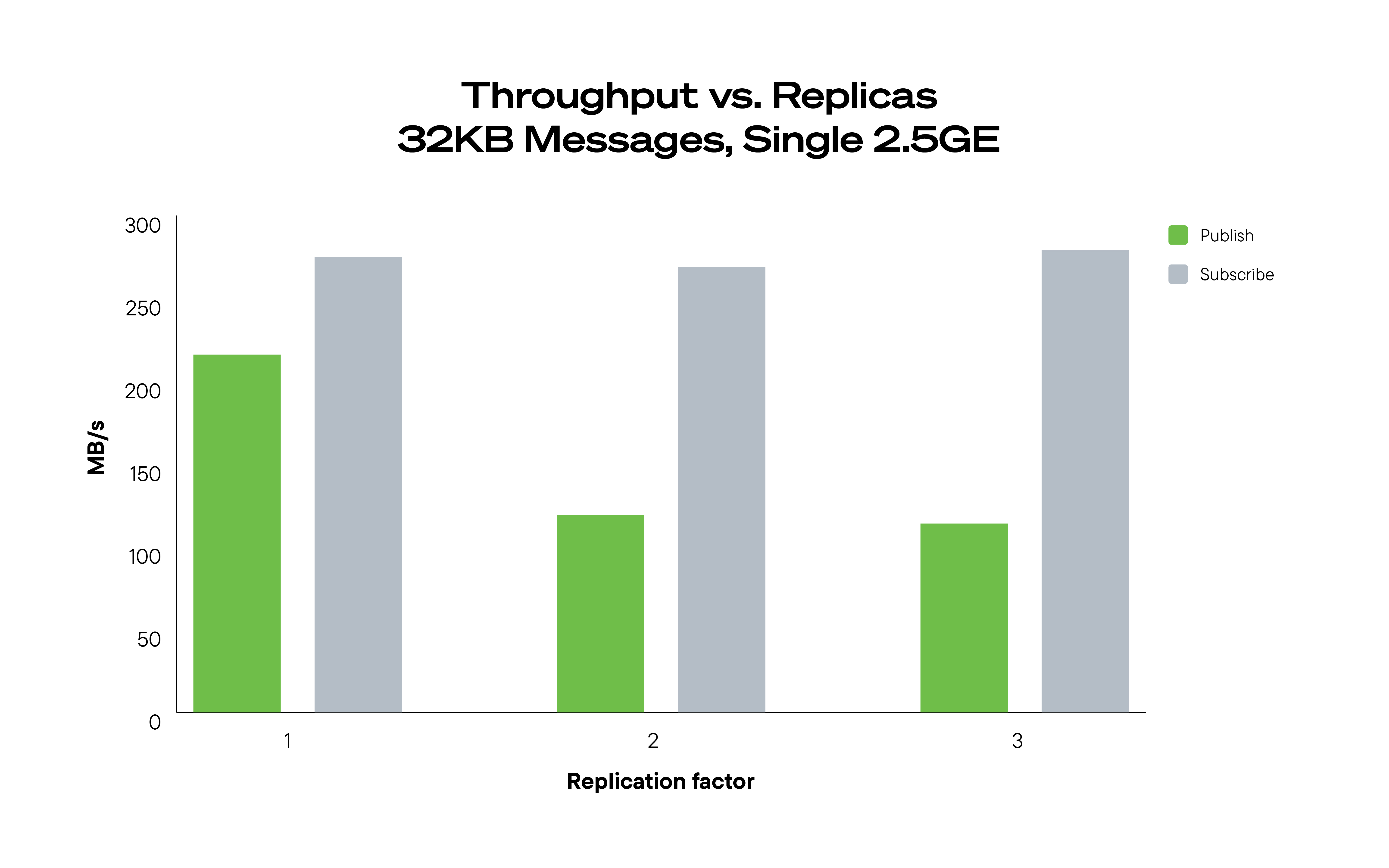

接下来我们分析了多节点复制如何影响性能。尽管数据复制增加了网络流量,但对读取性能的影响极小,这对于需要在多个节点间保持数据一致性的工作负载而言是一个关键优势。

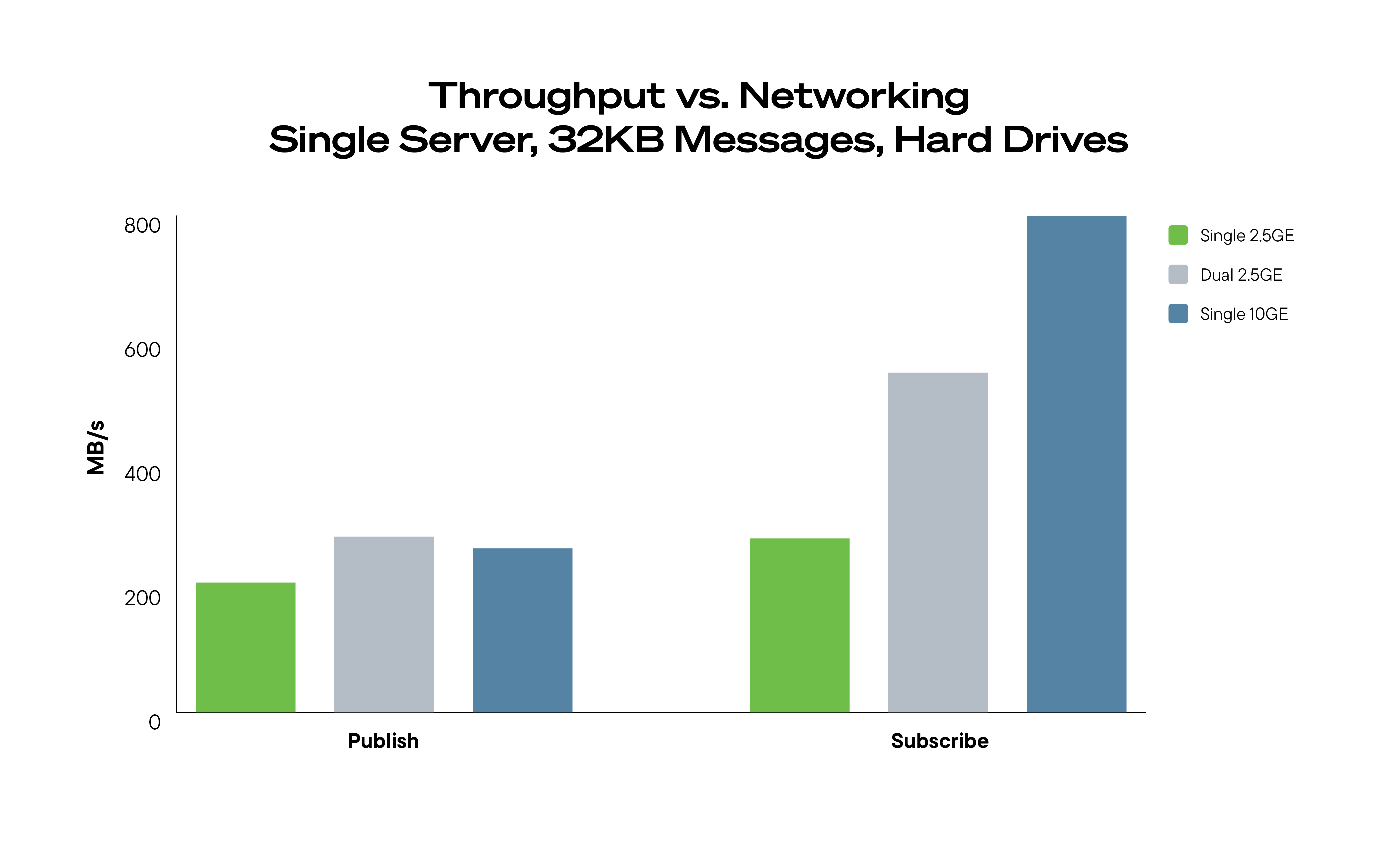

网络性能测试显示,添加第二条 2.5GE 链路仅带来轻微的写入性能提升,而 10GE 网络在某些特定场景下则显著改善了性能。

在边缘侧进行真实的 AI 训练

为了模拟 AI 工作流程,我们在该 NAS 系统上测试了一个真实的机器学习任务。我们使用包含 500 张带标签图像的数据集训练了一个船只分类模型,在本地运行特征提取和模型训练过程。

将图像存储在带有元数据标签的对象存储桶中后,我们使用 PyTorch Img2Vec 从每张图像中提取特征,然后训练随机森林分类器。生成的模型在一分钟内达到了 78% 的准确率。

本次测试的主要观察结果包括:

- 特征提取花费的时间最多 (81%),增加了对快速本地存储的需求。

- 一分钟内完成 AI 模型训练,证明本地 NAS 在 AI 工作流中的高效性。

- 没有经过正式 AI 培训的领域专家也能够成功运行实验,展示了这种方法的可及性。

本次实验表明,本地化 NAS 存储可以作为一种高性价比的 AI 数据中心,既能降低对云服务的依赖,又能提升数据访问性和系统性能。

总结:AI 存储必须不断演进

AI 的未来依赖于高效、具成本效益且可扩展的数据存储解决方案。随着数据量持续增长,组织必须重新思考如何存储和管理 AI 数据集。

本地化 NAS 解决方案为昂贵的云存储提供了一个切实可行的替代方案,使 AI 团队能够:

- 降低成本,同时保持对数据的高性能访问。

- 提高 AI 工作流效率,使数据靠近计算位置。

- 通过控制 AI 数据的驻留位置,增强合规性和自主性。

正如氧气维持生命,数据存储支撑着 AI 创新。让 AI 就绪的存储变得更易获取、更具性价比且性能更高,能够帮助组织加速实现以 AI 为驱动的突破性成果。