„Festplatten werden schon bald der Vergangenheit angehören.“

„Reine Flash-Arrays werden schon bald die Festplatten und Hybrid-Arrays im Rechenzentrum ersetzen.“

„Das Rechenzentrum der Zukunft wird rein auf Flash basieren.“

Willkommen im neuesten Kapitel des immer wieder kehrenden Märchens von der aussterbenden Festplatte. Diese Diskussion läuft seit über zehn Jahren – und die oben genannten Aussagen sind nur einige der falschen Annahmen. Die Prognosen einiger weniger lautstarker und – nennen wir sie optimistische Befürworter reiner Flash-Technik –, die das Ende der Festplatte verhergesagt hatten, haben sich bisher nicht bewahrheitet. Sie scheinen mit der Zeit jedoch immer dreister zu werden;

Flash-Speicher eignet sich ohne Frage sehr gut für Anwendungen, bei denen es auf hohe Leistung und Geschwindigkeit ankommt. Und der Umsatz mit Flash steigt ebenso wie der Umsatz mit reinen Flash-Arrays (AFA). Allerdings nicht auf Kosten der Festplatten. Die Annahme, die den Spekulationen über das Aussterben von Festplatten zugrunde liegt, ist zutiefst mit Mängeln behaftet.

Wir leben in einer Zeit, in der die Omnipräsenz der Cloud und das Aufkommen von KI den Wert großer Datensätze in die Höhe getrieben haben. Festplatten, auf denen heute der weitaus größte Teil der weltweiten Exabytes (EB) gespeichert wird, sind für die Betreiber von Rechenzentren unverzichtbarer denn je.

Selbst in den letzten Jahren, als die Flash-Preise vorübergehend auf ein Allzeittief fielen, haben Solid-State-Drives (SSDs) die Festplatten bei Workloads, die Massenspeicher erfordern, nicht verdrängt;

Branchenanalysten gehen davon aus, dass Festplatten der Hauptnutznießer des anhaltenden Speicherwachstums im Exabyte-Bereich sein werden. Das folgende Diagramm zeigt, dass dieses Wachstum hauptsächlich in Unternehmens- und großen Cloud-Rechenzentren zu finden sein wird, in denen die große Mehrheit der weltweiten Datensätze lagert. Relativ gesehen wird für Festplattenspeicher ein Wachstum von 6,996 EB prognostiziert, während SSDs zwischen 2022 und 2027 um 1,363 EB zulegen werden.1

Das ist kein Nullsummenspiel. In Rechenzentren haben Festplatten und Flash-Speicher schon immer zusammengearbeitet und wurden für verschiedener Services eingesetzt. Sie haben jeweils ihre eigenen Vorteile und Wertversprechen. In Zeiten generativer KI treiben eng mit Flash-Technologie gekoppelte Rechencluster indirekt den Bedarf an weiterem Festplattenspeicher im EB-Bereich voran,, , da die generierten Inhalte kostensparend gespeichert werden müssen.

Das ist kein Nullsummenspiel. In Rechenzentren haben Festplatten und Flash-Speicher schon immer zusammengearbeitet und wurden für verschiedener Services eingesetzt. Sie haben jeweils ihre eigenen Vorteile und Wertversprechen. In Zeiten generativer KI treiben eng mit Flash-Technologie gekoppelte Rechencluster indirekt den Bedarf an weiterem Festplattenspeicher im EB-Bereich voran,, , da die generierten Inhalte kostensparend gespeichert werden müssen.

Die Synergie der beiden Speichermedien hat nach wie vor Bestand. Der Vermutung, Festplatten seien veraltet, mangelt es an Glaubwürdigkeit und sie wird sich letztendlich nicht bewahrheiten;

Sehen wir uns die drei wichtigsten Mythen, die dieser Vermutung zugrunde liegen, genauer an – und die datengestützten Gründe, warum Festplatten in absehbarer Zukunft ein zentraler Bestandteil von Datenspeicherarchitekturen bleiben werden.

Wahrheit Nr. 1 – Das Preisgefälle

Mythos: Die Preise für SSDs werden sich bald den Preisen für Festplatten angleichen.

Realität: Die Preise für SSDs und Festplatten werden sich in den nächsten zehn Jahren zu keinem Zeitpunkt annähern.

Die Fakten sind eindeutig. Festplatten bieten einen deutlichen Kostenvorteil pro Terabyte (TB) gegenüber SSDs, was sie zum unbestrittenen Eckpfeiler der Speicherinfrastruktur in Rechenzentren macht;

Obwohl die Preise für NAND-Flash-Speicher weiterhin sehr volatil sind und aufgrund der schwachen Nachfrage und des Überangebots im Jahr 2023 einen Tiefpunkt erreicht haben, prognostiziert das Analystenunternehmen Forward Insights ab 2024 und bis 2025 einen Preisanstieg für SSDs. Nach einem drastischen Preisverfall werden die SSD-Anbieter diesen Umschwung begrüßen, nachdem sie mit dem Abbau von Altbeständen und der Senkung der Investitionsausgaben zu kämpfen hatten, um das Angebot an die Nachfrage anzupassen. In der Folge kommt es bereits zu Preissteigerungen für NAND-basierte Lösungen;

Die von Seagate durchgeführte Analyse von Forschungsergebnissen von IDC, TRENDFOCUS und Forward Insights bestätigt, dass Festplatten für die meisten Unternehmensaufgaben weiterhin die kostengünstigste Option darstellen. Der Preisunterschied pro TB zwischen Enterprise-SSDs und Enterprise-Festplatten wird voraussichtlich bis mindestens 2027 bei einem Verhältnis von 6:1 oder darüber bleiben;

Dieses Preis-pro-TB-Gefälle zeigt sich besonders im Rechenzentrum, wo die Anschaffungskosten für Geräte den mit Abstand größten Teil der Gesamtbetriebskosten (TCO) ausmachen. Berücksichtigt man alle Kosten des Speichersystems, einschließlich der Kosten für die Anschaffung von Geräten, Strom, Netzwerk und Rechenleistung, so weisen festplattenbasierte Systeme pro TB gerechnet weitaus bessere TCO auf.

In dem Versuch, diese unbestreitbaren Unterschiede bei den Gesamtbetriebskosten und Preisen zu umgehen, haben einige AFA-OEMs damit begonnen, ihre eigenen kundenspezifischen High-Density-NAND-Bausteine mit einer Kapazität von Hunderten von TBs zu entwickeln. Das Problem bei dieser Logik ist, dass eine dramatisch höhere NAND-Dichte in einem einzelnen Gerät oder System immer noch nichts an dem markanten Kostenunterschied pro TB bei den Rohmedien ändert.

Eine weitere Strategie, um von den Nachteilen der Kosten pro TB abzulenken, hat mit den sogenannten „TBe“ oder den „effektiven Terabytes“ zu tun. Es wurde festgestellt, dass ein Solid-State-Drive aufgrund von Techniken zur Datenreduzierung (z. B. Datenkomprimierung) erheblich mehr Speicherplatz bieten kann, als es die reine Kapazität vermuten lässt. Bei großen Bereitstellungen findet die Datenreduzierung jedoch weiter oben im Stack statt, wodurch sie auf Speicherebene irrelevant wird. Außerdem ist eine Datenkomprimierung in den meisten Unternehmens- und Cloud-Anwendungsfällen angesichts der zunehmenden Konzentration auf den Datenschutz und der Prävalenz der Verschlüsselung oft nicht durchführbar. Verschlüsselte Daten können nicht komprimiert werden, da ihre Entropie so hoch ist, dass es kein Muster zur Vereinfachung gibt.

Fazit: Auch wenn sich Flash für spezifische und leistungsintensive Aufgaben bewährt hat, bleiben in Rechenzentren zur Bereitstellung von Speicher im EB-Bereich Festplatten das Mittel der Wahl, da sie für die absehbare Zukunft eine zuverlässige, wirtschaftliche und weit verbreitete Lösung darstellen.

Wahrheit Nr. 2 – Produktionskapazitäten

Mythos: Das Angebot an NAND kann die gesamte Festplattenkapazität ersetzen.

Realität: Festplatten vollständig durch NAND-Speicher zu ersetzen, würde untragbare Investitionskosten verursachen.

Die Vorstellung, die NAND-Industrie würde oder könnte ihre Fertigung schnell erhöhen, um die gesamte Festplattenkapazität zu ersetzen, ist nicht nur optimistisch – ein solcher Versuch würde zu ihrem finanziellen Ruin führen. Bei der Umstellung von Festplatten auf NAND geht es nicht nur darum, mehr Einheiten zu produzieren. Die Umsetzung wäre ein finanzielles und logistisches Mammutprojekt, das nicht zu einem Preis realisierbar ist, der gegenüber Festplatten konkurrenzfähig wäre.

Laut demNAND Market Monitor-Bericht für das 4. Quartal 2023 des Branchenanalysten Yole Intelligence hat die gesamte NAND-Industrie von 2015 bis 2023 3,1 Zettabyte (ZB) ausgeliefert, während sie gleichzeitig ganze 208 Milliarden US-Dollar investieren musste – etwa 47 % ihres Gesamtumsatzes.

Im Gegensatz dazu deckt die Festplattenindustrie den überwiegenden Teil – fast 90 % – des Speicherbedarfs in Rechenzentren auf äußerst kapitalschonende Weise ab. Um dies zu veranschaulichen, verwenden wir als Beispiel Seagate Technology stellvertretend für die Festplattenindustrie. Zwischen 2015 und 2023 lieferte Seagate 3,5 ZB an Speicher aus. In diesen acht Jahren investierte Seagate insgesamt 4,3 Milliarden US-Dollar, was nur etwa 5 % des gesamten Umsatzes mit Festplatten ausmachte. Das entspricht etwa 67 Milliarden US-Dollar pro ZB für die NAND-Branche gegenüber etwa 1 Milliarde US-Dollar pro ZB für die Festplattenproduktion (repräsentiert von Seagate). Die Festplatte ist das deutlich wirtschaftlichere Speichermedium für die Bereitstellung von Speicher im ZB-Bereich in Rechenzentren. Seagates Analyse von Prognosen von IDC für Festplatten und von Forward Insights für SSDs zeigt, dass die Produktion von Festplatten im EB-Bereich im Jahr 2024 fast dreimal so hoch sein wird wie die von SSDs Im selben Jahr wird die Produktion von Festplatten im EB-Bereich in Unternehmen und Rechenzentren sechsmal so hoch sein wie die von SSDs;

Kürzlich haben einige AFA-Anbieter behauptet, dass die Flash-Industrie die gesamte Festplattenkapazität bis 2028 vollständig ersetzen könnte. Sehen wir uns an, welche Investitionen die NAND-Branche dafür tätigen müsste.

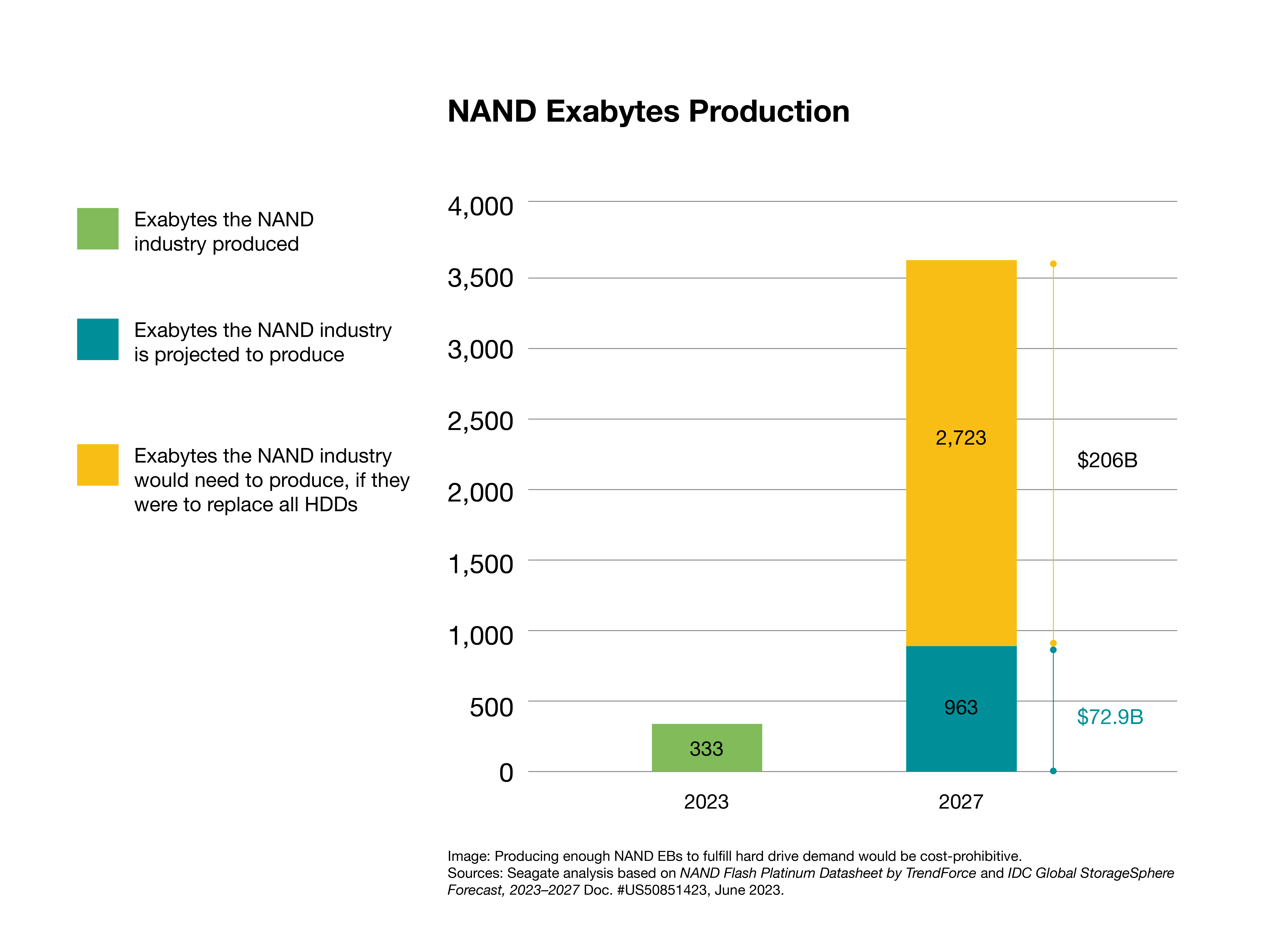

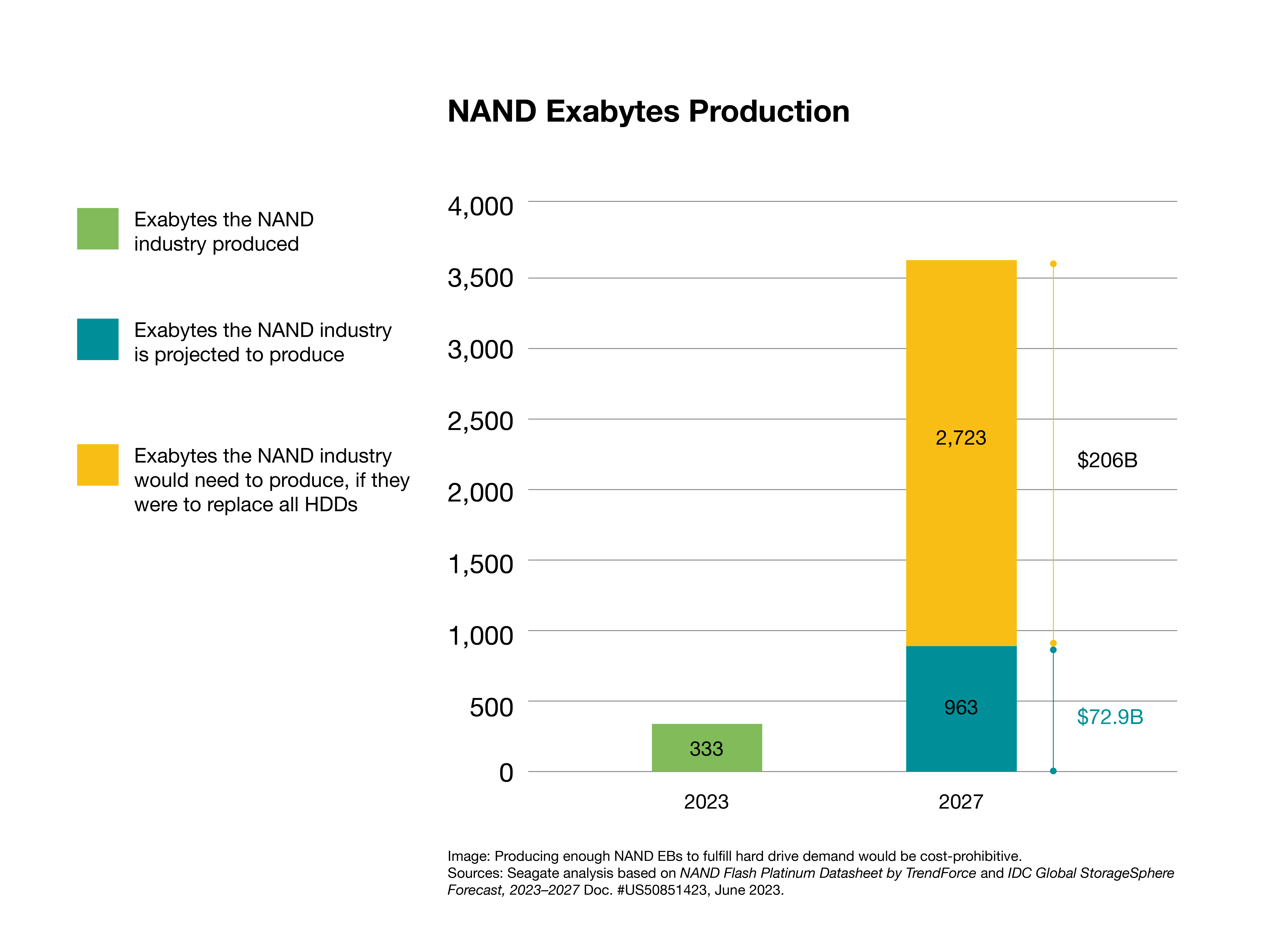

Aus dem oben zitierten Bericht von Yole Intelligence geht hervor, dass die NAND-Industrie von 2025 bis 2027 etwa 73 Milliarden US-Dollar investieren wird, was eine Produktion von schätzungsweise 963 EB für Unternehmens-SSDs sowie andere NAND-Produkte für Tablets und Telefone ergeben wird. Das entspricht einer Investition von etwa 76 US-Dollar pro TB an produziertem Flash-Speicher. Bei Anwendung desselben Kapitalpreises pro Bit wären zusätzliche Investitionen in Höhe von 206 Mrd. USD erforderlich, um die für 2027 prognostizierte Festplattenkapazität von 2,723 ZB zu erreichen. Insgesamt sind das fast 279 Milliarden Dollar an Investitionen für einen adressierbaren Gesamtmarkt von etwa 25 Milliarden Dollar.

Es ist offensichtlich, dass dieses Investitionsniveau für eine Branche, die mit unsicheren Erträgen konfrontiert ist, unwahrscheinlich ist, vor allem angesichts der Verluste im Jahr 2023.

Die neuesteNAND Flash Platinum Datasheet von TrendForce zeigt, dass im Jahr 2024 weltweit etwa 28 NAND-Herstellungsanlagen (Fabs) in Betrieb sein werden. Wenn wir die im Oktober 2022 eröffnete Fab7 Phase 1 von Kioxia als Beispiel nehmen, kostet der Neubau einer einzigen NAND-Fabrik etwa 6,8 Milliarden US-Dollar. Die von der NAND-Industrie benötigten zusätzlichen Investitionen in Höhe von 206 Mrd. USD würden also ungefähr 30 neuen Fabriken entsprechen. Diese Anlagen müssten gebaut, skaliert, getestet, qualifiziert und in den nächsten drei bis vier Jahren die Produktion voll hochgefahren werden. Damit würde sich die Anzahl der NAND-Fabs weltweit in weniger als vier Jahren verdoppeln;

Darüber hinaus zeigt der StorageSphere-Bericht2 2023 von IDC, dass im Jahr 2023 das Verhältnis von vorhandener Festplatten- zu installierter SSD-Kapazität in Cloud- und Nicht-Cloud-Rechenzentren 7 zu 1 betrug. IDC prognostiziert, dass dieses dominante Verhältnis von HDD-basierten EBs für die absehbare Zukunft bei 6 bis 7:1 bleiben und bei einer jährlichen Wachstumsrate (CAGR) von 26 % liegen wird, was zu einer installierten HDD-Kapazität von bis zu 10 ZB im Jahr 2027 führen wird. Daher müsste die NAND-Industrie nicht nur, wie zuvor beschrieben, Jahr für Jahr die gesamte künftige Jahresproduktion neuer Festplatteninstallationen ersetzen, sondern auch investieren, um den alternden Teil dieser installierten Basis von 10 ZB an Festplatten für Rechenzentren zu ersetzen, wenn diese das Ende ihres Lebenszyklus erreichen – eine zusätzliche Investition, die weit über die 206 Milliarden US-Dollar hinausgeht, die allein für den Ersatz der 2,723 ZB Festplattenkapazität benötigt werden, die voraussichtlich im Jahr 2027 geliefert werden.

NAND-Lösungen sind für bestimmte Workloads in Rechenzentren effizient, aber die Vorstellung, dass Rechenzentren sich vollständig auf sie verlassen werden, ist mit vielen Unabwägbakeiten behaftet. Abgesehen von den Risiken und der Unwahrscheinlichkeit, dass die NAND-Industrie das Angebot an Festplatten ersetzt, stellen die Preisschwankungen eine weitere Unsicherheit für Unternehmen dar, die auf der Suche nach einer stabilen Versorgung und den besten Gesamtbetriebskosten für ihren Speicher sind.

Die Vorstellung, dass NAND-Speicher Festplatten in absehbarer Zeit vollständig ersetzen könnte, ist höchst unwahrscheinlich, wenn nicht gar unmöglich. Dazu müsste die Branche enorme finanzielle und logistische Hürden überwinden und große Summen an Kapital und Technik investieren, und zwar in einen Markt, der nicht auf eine große Umstellung der derzeitigen Rechenzentrumsarchitekturen vorbereitet ist.

Wahrheit Nr. 3 – Workload-Profile

Mythos: Nur AFAs können den Leistungsanforderungen moderner Unternehmens-Workloads gerecht werden.

Realität: Enterprise-Speicher setzt sich in der Regel aus verschiedenen Speichermedien wie Festplatten- oder Hybrid-Arrays, Flash und Bandlaufwerke zusammen, um Kosten, Kapazität und Leistung an die jeweiligen Workloads anzupassen.

Diesem Problem liegt eine falsche Dichotomie zugrunde. Anbieter reiner Flash-Lösungen raten Unternehmen, aus Gründen der „Vereinfachung“ und „Zukunftssicherheit“ nur auf leistungsstarke Flash zu setzen. Andernfalls besteht die Gefahr, dass das Unternehmen mit den Leistungsanforderungen moderner Workloads nicht Schritt halten kann. Diese Nullsummenlogik scheitert aus folgenden Gründen:

- Die überwiegende Mehrheit der modernen Workloads erfordert den von Flash-Speicher gebotenen Leistungsvorteil nicht.

- Unternehmen mit knappen Budgets und schnell wachsenden Datenbeständen müssen einen Kompromiss zwischen Kapazität, Kosten und Leistung schließen.

- Die vermeintliche Einfachheit einer einstufigen Speicherarchitektur ist eine Lösung auf der Suche nach einem Problem.

Betrachten wir diese Punkten im Einzelnen.

Erstens sind die meisten Daten der Welt in der Cloud und in großen Rechenzentren gespeichert. In diesen Umgebungen folgen die Arbeitslasten der Pareto-Regel: Ein erheblicher Anteil der verfügbaren Leistung wird nur von einem kleinen Anteil der Workloads in Anspruch genommen. Aus diesem Grund haben laut IDC in den letzten fünf Jahren Festplatten fast 90 % der installierten Speicherbasis von Cloud-Serviceanbietern und Hyperscale-Rechenzentren ausgemacht.

Werfen Sie einen Blick auf die nachstehende Grafik, die aus der IDC-Studie Global DataSphere 2023 stammt. Der Großteil der weltweiten Daten ist Teil von Workloads, die für allgemeine Anwendungsfälle eine nominelle Datenübertragungszeit benötigen.

In einigen Fällen sind reine Flash-Systeme als Bestandteil der leistungsstärksten Lösungen gar nicht erforderlich. Es gibt hybride Speichersysteme, die vergleichbar oder sogar schneller sind als reine Flash-Systeme. Auf Geräteebene sind die Leistungsunterschiede offensichtlich. Im großen Maßstab in den Racks von Rechenzentren profitiert die Festplattenleistung jedoch von einem extrem parallelen Zugriff, was zu einem Leistungsniveau führt, das mehr als ausreichend für die meisten Workloads wie KI und maschinelles Lernen ist. Ebenso wichtig ist, dass alle signifikanten Leistungsvorteile von Flash, oft durch andere infrastrukturelle Gegebenheiten, wie z. B. Netzwerkkapazität oder -qualität, eingeschränkt werden können;

Zweitens sind, wie bereits in diesem Artikel erwähnt, für die meisten Entscheidungen hinsichtlich der Rechenzentrumsinfrastruktur die Gesamtbetriebskosten der ausschlaggebende Faktor. Daher muss ein Kompromiss zwischen Kosten, Kapazität und Leistung gefunden werden. Optimale Gesamtbetriebskosten werden durch die Auswahl der kostengünstigsten Medien (Festplatten, Flash-Speicher oder Tape) für die Workload-Anforderungen erzielt. Festplatten und Hybrid-Arrays (bestehend aus Festplatten und SSDs) eignen sich hervorragend für die meisten Unternehmen sowie Cloud-Speicher und -Anwendungen.

Natürlich kann man SSDs oder AFAs für Workloads verwenden, die am besten für Festplatten geeignet sind, z. B. Dateidienste, Objektspeicher, Dokumentenverwaltungssysteme oder Webhosting. Doch je höher die Kapazität, desto unlogischer ist eine solche Entscheidung aus Kostengründen. Das ist so, als würde man sein Auto, das in einer Garage geparkt ist, zur Aufbewahrung seiner Kleidung benutzen. Ist das machbar? Sicher, wenn Sie dafür ein Auto verwenden möchten. Aber ist das wirtschaftlich? Nein, ganz und gar nicht.

Flash-Speicher bietet zwar hervorragende Leistung in leseintensiven Szenarien, allerdings nimmt seine Langlebigkeit mit zunehmender Schreibaktivität ab. Hersteller begegnen diesem Problem mit Fehlerkorrekturen und Over-Provisioning, also zusätzlichem, nicht sichtbarem Speicher, um verschlissene Zellen zu ersetzen. Diese Lösungen sind jedoch mit Zusatzkosten verbunden: Over-Provisoning erhöht die Kosten für das eingebettete Produkt erheblich, und zur Vermeidung von Datenverlusten ist eine konstante Stromversorgung erforderlich. Dies stellt in Umgebungen wie Rechenzentren am Netzwerkrand oder Umgebungen, in denen ein kontinuierlicher Betrieb nicht garantiert ist und wo der Verschleiß durch hohe Temperaturen beschleunigt wird, eine Herausforderung dar;

Und während Technologien wie Triple Level Cell (TLC) und Quad Level Cell (QLC) dafür sorgen, dass Flash-Speicher datenintensive Workloads mit der Zuverlässigkeit einer Festplatte bewältigen kann, schwächelt die Wirtschaftlichkeit bei größeren Datensätzen oder bei Langzeitspeicherung. In diesen Fällen bieten Festplatten mit ihrer wachsenden Flächendichte eine kostengünstigere Lösung. In Hyperscale-Umgebungen wird durch den parallelen Einsatz von Tausenden von Festplatten eine Leistung erzielt, die Flash-Speicher ergänzt vergleichbar ist, was ihre Bedeutung in modernen Rechenzentren unterstreicht.

Folglich übernimmt QLC-Flash zwar einen beträchtlichen Prozentsatz des TLC-Marktes – ähnlich wie TLC die Multi-Level-Cell (MLC)-NAND-Speicher verdrängt hat –, aber aufgrund der in diesem Artikel untersuchten Faktoren Kosten, Verfügbarkeit und Workload wird der Marktanteil von Festplatten nicht erodieren.

Der dritte und damit zusammenhängende Punkt ist die Behauptung, dass AFAs Hybrid-Arrays oder Festplattenspeichersystemen überlegen sind. Die Flash-Befürworter behaupten, dass die Verwendung eines einzigen Speichertyps „einfacher“ sei, als eine Mischung aus verschiedenen Medien und Speicherschichten. Nur nicht so voreilig.

Viele hybride Speichersysteme nutzen eine bewährte und fein abgestimmte softwaredefinierte Architektur, die die Stärken unterschiedlicher Medien nahtlos in einzelne Einheiten integriert und nutzt. In Scale-Out-Architekturen für Rechenzentren von Private- oder Public-Clouds werden Dateisysteme oder softwaredefinierter Speicher verwendet, um die Datenspeicher-Workloads über Rechenzentrumsstandorte und Regionen hinweg zu verwalten. Sie bieten eine mehr als angemessene Flexibilität, denn sie ermöglichen es Unternehmen, ihre Speicherkapazität an sich ständig ändernde Anforderungen anzupassen.

AFAs und SSDs eignen sich hervorragend für leseintensive Hochleistungs-Workloads. Es ist jedoch ein Fehler, Nischenanwendungen oder kleine Bereitstellungen auf den Massenmarkt und Hyperscale-Bereitstellungen zu übertragen, bei denen AFAs eine unnötig teure Möglichkeit darstellen, um das zu erreichen, was Festplatten bereits bieten, und zwar zu geringeren Gesamtbetriebskosten.

Für Cloud-, Hyperscale- und große Unternehmens-Speicherarchitekturen wird ein Speicher ausgewählt, der Kosten, Kapazität und Leistung optimiert. Festplatten eignen sich für Workloads, für die Flash-Speicher nicht geeignet sind. Flash eignet sich für Workloads, für die sich Festplatten nicht eignen. Beide Medien werden im Rechenzentrum koexistieren, wobei Festplatten hinsichtlich der auf absehbare Zeit gespeicherten EBs weiterhin den Großteil ausmachen werden.

Für Cloud-, Hyperscale- und große Unternehmens-Speicherarchitekturen wird ein Speicher ausgewählt, der Kosten, Kapazität und Leistung optimiert. Festplatten eignen sich für Workloads, für die Flash-Speicher nicht geeignet sind. Flash eignet sich für Workloads, für die sich Festplatten nicht eignen. Beide Medien werden im Rechenzentrum koexistieren, wobei Festplatten hinsichtlich der auf absehbare Zeit gespeicherten EBs weiterhin den Großteil ausmachen werden.

Apropos EBs: Häufig werden steigende SSD-Stückzahlen in Verbindung mit rückläufigen Festplattenauslieferungen als Beweis für einen Wendepunkt im Speichermarkt aufgeführt. Dieses Argument ist jedoch ein Trugschluss, denn es verkennt, dass die Festplattenkapazitäten und die Gesamtzahl der ausgelieferten Festplatten schneller denn je zunehmen. Ein typisches Beispiel: Die neue Mozaic™-Plattform von Seagate wird dank innovativer HAMR-gestützter Flächendichte eine Verdoppelung der maximalen Speicherkapazität innerhalb der nächsten vier Jahre ermöglichen. Bei der herkömmlichen PMR-Technologie (Perpendicular Magnetic Recording) bräuchte man neun Jahre, um die Kapazität zu verdoppeln.

Ausschlaggebend für die genaue Messung des Wachstums sind nicht die Stückzahlen, sondern die EB-Lieferungen. Analysten gehen davon aus, dass die Auslieferungen von EBs in Form von Festplatten weiterhin in einem noch nie dagewesenen Tempo steigen werden. Und obwohl Flash-Speicher ebenfalls ein Wachstum verzeichnen werden, werden sie in Bezug auf die installierte Kapazität nicht an Festplatten heranreichen;

Die von Seagate durchgeführte Analyse der Daten von IDC und TRENDFOCUS prognostiziert einen Anstieg der EB-Vorhersagen für Festplatten um fast 250 % bis 2028. Bei einer perspektivischen Extrapolation bleibt dieses Verhältnis bis weit in das nächste Jahrzehnt hinein bestehen. Sehen Sie sich Folgendes an:

Fazit – Auf lange Sicht unverzichtbar

Die vermeintliche Veralterung von Festplatten wird in der Technikbranche bereits seit mehr als einem Jahrzehnt kontrovers diskutiert. Die verschiedenen Prognosen haben sich nicht wirklich bewahrheitet. Wir gehen davon aus, dass sich auch die jüngsten Prophezeiungen nicht erfüllen werden.

Fast immer versuchen ausschließliche Anhänger von reinen Flash-Systemen, ihre Argumente mit logischen Irrtümern zu untermauern, indem sie von einer kleinen Untergruppe von Anwendungsfällen auf den Massenmarkt extrapolieren – und das ist der Punkt, an dem ihre Schlussfolgerungen nicht zutreffen.

Das ist bestenfalls kreatives Marketing.

Tatsächlich gilt Folgendes:

- Die Preise für NAND und Festplatten werden sich in absehbarer Zeit nicht annähern, vor allem nicht mit der beschleunigten Erhöhung der Flächendichte von Festplatten, die durch die Serienproduktion der Mozaic 3+-Plattform von Seagate ermöglicht wird.

- Anders als von manchen suggeriert, werden NAND-Hersteller ihre Produktionskapazitäten nicht skalieren können, um die aktuelle und künftige Nachfrage nach EBs zu erfüllen. Aufgrund der erforderlichen Investitionen ist es für AFA-Anbieter unmöglich, sowohl ein ausreichendes Angebot als auch eine günstigere Speicherkapazität als mit Festplatten anzubieten. Es ist unwahrscheinlich, dass die AFA-Hersteller Hunderte von Milliarden Dollar aufbringen können, um mit einem Verlust von 10:1 genügend NAND herzustellen, um Festplatten zu ersetzen;

- Betreiber großer Cloud- und Enterprise-Rechenzentren sind pragmatisch und verstehen, dass Scale-Out-Speicherarchitekturen eine Mischung von Medien erfordern, die für die Budget-, Kapazitäts- und Leistungsanforderungen ihrer Workloads optimiert sind.

Natürlich gibt es noch weitere Mythen, die zu dem „kreativen Marketing“ beitragen, das das Ende von Festplatten vorhersagt – Mythen über Nachhaltigkeit, Stromverbrauch, Zuverlässigkeit und andere Aspekte. Bleiben Sie dran: Wir werden diesen Themen in den kommenden Posts auf den Grund gehen. Die drei oben angesprochenen Mythen scheinen uns jedoch die wichtigsten zu sein.

Jede ernsthafte Untersuchung der in diesem Artikel dargelegten Daten führt zu der Schlussfolgerung, dass Festplatten nicht verschwinden werden. Sie werden auch in Zukunft den größten Teil der weltweiten Daten speichern.

Etwas anderes zu behaupten, ist reines Wunschdenken.

Das ist kein Nullsummenspiel. In Rechenzentren haben Festplatten und Flash-Speicher schon immer zusammengearbeitet und wurden für verschiedener Services eingesetzt. Sie haben jeweils ihre eigenen Vorteile und Wertversprechen. In Zeiten generativer KI treiben eng mit Flash-Technologie gekoppelte Rechencluster indirekt den Bedarf an weiterem Festplattenspeicher im EB-Bereich voran,, , da die generierten Inhalte kostensparend gespeichert werden müssen.

Das ist kein Nullsummenspiel. In Rechenzentren haben Festplatten und Flash-Speicher schon immer zusammengearbeitet und wurden für verschiedener Services eingesetzt. Sie haben jeweils ihre eigenen Vorteile und Wertversprechen. In Zeiten generativer KI treiben eng mit Flash-Technologie gekoppelte Rechencluster indirekt den Bedarf an weiterem Festplattenspeicher im EB-Bereich voran,, , da die generierten Inhalte kostensparend gespeichert werden müssen.

Für Cloud-, Hyperscale- und große Unternehmens-Speicherarchitekturen wird ein Speicher ausgewählt, der Kosten, Kapazität und Leistung optimiert. Festplatten eignen sich für Workloads, für die Flash-Speicher nicht geeignet sind. Flash eignet sich für Workloads, für die sich Festplatten nicht eignen. Beide Medien werden im Rechenzentrum koexistieren, wobei Festplatten hinsichtlich der auf absehbare Zeit gespeicherten EBs weiterhin den Großteil ausmachen werden.

Für Cloud-, Hyperscale- und große Unternehmens-Speicherarchitekturen wird ein Speicher ausgewählt, der Kosten, Kapazität und Leistung optimiert. Festplatten eignen sich für Workloads, für die Flash-Speicher nicht geeignet sind. Flash eignet sich für Workloads, für die sich Festplatten nicht eignen. Beide Medien werden im Rechenzentrum koexistieren, wobei Festplatten hinsichtlich der auf absehbare Zeit gespeicherten EBs weiterhin den Großteil ausmachen werden.