„Dyski twarde wkrótce staną się przeszłością”.

„Macierze all-flash już niedługo zastąpią dyski i macierze hybrydowe w centrach danych”.

„Centra danych przyszłości to dyski typu all-flash”.

Witamy w najnowszej odsłonie odwiecznej sagi o dyskach twardych jako gatunku na wymarciu. Debata – której fragmenty zostały przedstawione powyżej – trwa już ponad dekadę. Przewidywania wieszczące koniec dysków twardych, wypowiadane przez kilku głośnych i, można powiedzieć, optymistycznie nastawionych zwolenników technologii flash, źle się zestarzały przez lata. Ale ich zapowiedzi wydają się z czasem stawać coraz bardziej nachalne.

Pamięć masowa typu flash bez wątpienia doskonale nadaje się do obsługi aplikacji, które wymagają wysokiej wydajności i szybkości. Przychody ze sprzedaży pamięci flash rosną, podobnie jak przychody z macierzy all-flash (AFA). Ale nie kosztem dysków twardych. Przesłanki leżące u podstaw spekulacji na temat śmierci dysków twardych są całkowicie błędne.

Żyjemy w czasach, kiedy wszechobecność chmury i pojawienie się sztucznej inteligencji zwiększyło wartość ogromnych zestawów danych. Dyski twarde, na których obecnie zapisywana jest zdecydowana większość eksabajtów (EB) na świecie, są bardziej niezbędne operatorom centrów danych niż kiedykolwiek wcześniej.

Nawet w ostatnich latach, kiedy ceny pamięci flash tymczasowo spadły do najniższego poziomu, dyski półprzewodnikowe (SSD) nie wyparły dysków twardych w środowiskach wymagających pojemnej pamięci masowej danych.

Analitycy branżowi przewidują, że głównym beneficjentem stałego wzrostu EB będą dyski twarde. Poniższy wykres pokazuje, że korporacyjne i wielkoskalowe centra danych w chmurze – gdzie umieszcza się zdecydowaną większość światowych zbiorów danych – będą miejscem, gdzie nastąpi ten rozwój. W wartościach względnych, przewiduje się, że w latach 2022–2027.1 ilość pamięci masowej na dyskach twardych wzrośnie o 6996 EB, podczas gdy na dyskach SSD przechowywane będzie o 1363 EB więcej.

To nie jest gra o sumie zerowej. W centrach danych dyski twarde i pamięć flash zawsze pracowały w synergii i były instalowane do obsługi różnych usług. Oba typy pamięci mają swoje unikatowe zalety i propozycje wartości. W rzeczywistości w erze generatywnej sztucznej inteligencji klastry komputerowe ściśle powiązane z pamięcią flash pośrednio generują zapotrzebowanie na więcej eksabajtów na dyskach twardych, ponieważ tworzone treści muszą być przechowywane w ekonomiczny sposób.

To nie jest gra o sumie zerowej. W centrach danych dyski twarde i pamięć flash zawsze pracowały w synergii i były instalowane do obsługi różnych usług. Oba typy pamięci mają swoje unikatowe zalety i propozycje wartości. W rzeczywistości w erze generatywnej sztucznej inteligencji klastry komputerowe ściśle powiązane z pamięcią flash pośrednio generują zapotrzebowanie na więcej eksabajtów na dyskach twardych, ponieważ tworzone treści muszą być przechowywane w ekonomiczny sposób.

Ta synergia nośników pamięci masowej działa i ma się dobrze, a domniemanie, że dyski twarde to przestarzała technologia, jest mało wiarygodne i ostatecznie okaże się fałszywe.

Przyjrzymy się bliżej trzem kluczowym mitom leżącym u podstaw tego przypuszczenia i odpowiemy na pytanie, dlaczego dyski twarde pozostaną w centrum architektury pamięci masowej danych w przewidywalnej przyszłości.

Prawda nr 1 – Rozbieżność cen

Mit: Ceny dysków SSD wkrótce zrównają się z cenami dysków twardych.

Rzeczywistość: W ciągu następnej dekady ceny dysków twardych i dysków SSD nie zbliżą się.

Dane wskazują na co innego. Dyski twarde mają zdecydowaną przewagę pod względem kosztu na terabajt (TB) nad dyskami SSD, co pozycjonuje je jako niekwestionowany kamień węgielny infrastruktury pamięci masowej w centrum danych.

Mimo że ceny pamięci flash typu NAND są bardzo zmienne i w 2023 roku osiągnęły najniższy poziom z powodu niskiego popytu i nadpodaży, firma analityczna Forward Insights przewiduje powrót do wcześniejszego poziomu cen dysków SSD, który rozpocznie się w 2024 roku i potrwa do 2025 roku. Po gwałtownych spadkach cen producenci dysków SSD przyjmą tę zmianę z zadowoleniem, ponieważ starają się zredukować starzejące się zapasy i wydatki kapitałowe oraz dostosować podaż do popytu. Zaczęliśmy już dostrzegać wzrost cen rozwiązań opartych na pamięci NAND.

Przeprowadzona przez Seagate analiza badań przygotowanych przez IDC, TRENDFOCUS oraz Forward Insights potwierdza, że dyski twarde pozostaną najbardziej opłacalną opcją do realizacji większości zadań w przedsiębiorstwach. Przewiduje się, że różnica cenowa w relacji na TB dla dysków SSD i dysków twardych klasy enterprise będzie utrzymywać się na poziomie 6 do 1 lub wyższym co najmniej do 2027 roku.

Ta różnica w zakresie ceny na TB jest szczególnie widoczna w centrum danych, gdzie koszt urządzenia jest zdecydowanie dominującym składnikiem całkowitego kosztu posiadania (TCO). Biorąc pod uwagę wszystkie koszty systemu pamięci masowej – w tym koszty nabycia urządzeń, zasilania, sieci i koszty mocy obliczeniowej – znacznie lepszy całkowity koszt posiadania dysków twardych według przelicznika kosztów na TB jest szczególnie widoczny.

Podejmując próbę obejścia tych nieuchronnych rozbieżności w zakresie TCO i cen, niektórzy producenci AFA OEM zaczęli projektować własne urządzenia NAND o dużej gęstości i pojemnościach sięgających setek TB, twierdząc, że na poziomie systemu teoretyczne korzyści w zakresie TCO wykraczają poza oszczędności przy zakupie urządzenia. Problem z tym argumentem polega na tym, że zwiększenie poziomu gęstości pamięci NAND pojedynczego urządzenia lub systemu nie zmienia całkowitego kosztu na TB rozróżniającego nośniki pamięci.

Inną taktyką stosowaną w celu odwrócenia uwagi od kosztu na TB są tzw. „TBe”, czyli „efektywne terabajty”. Twierdzi się, że dzięki zastosowaniu technik redukcji danych (np. kompresji danych) dysk SSD może oferować znacznie więcej miejsca na pamięć masową, niż wynika to z jego znamionowej pojemności. W dużych instalacjach redukcja danych odbywa się jednak na wyższych poziomach stosu, więc na poziomie pamięci masowej nie ma to znaczenia. Ponadto, biorąc pod uwagę zwiększony nacisk na ochronę danych i powszechność szyfrowania, w większości zastosowań w przedsiębiorstwach i w chmurze kompresja danych jest często niewykonalna. Gdy dane są szyfrowane, nie mogą być kompresowane, ponieważ ich entropia jest tak duża, że nie można zastosować schematu upraszczającego.

Wnioski: Pamięć flash przoduje w realizacji specyficznych zadań wymagających wysokiej wydajności, ale dyski twarde będą nadal głównym miejscem docelowym dla eksabajtów w centrum danych, oferując w przewidywalnej przyszłości niezawodne, efektywne kosztowo i powszechnie stosowane rozwiązanie.

Prawda nr 2 – Skala produkcji

Mit: Podaż pamięci NAND może szybko zastąpić całą pojemność dostępną na dyskach twardych.

Rzeczywistość: Całkowite zastąpienie dysków twardych pamięcią NAND wymagałoby niemożliwych do utrzymania nakładów kapitałowych.

Pogląd, że podaż pamięci NAND zwiększy się lub może się szybko zwiększyć tak, aby zastąpić całą pojemność dysków twardych, jest nie tylko nazbyt optymistyczny – taka próba doprowadziłaby do finansowej katastrofy. Przejście z dysków twardych na pamięć NAND nie polega tylko na produkcji większej liczby dysków. Realizacja takiego planu byłaby ogromnym finansowym i logistycznym przedsięwzięciem, nie mówiąc już o cenie, która musiałaby być konkurencyjna w stosunku do dysków twardych.

Według raportu branżowego za IV kwartał 2023 r. NAND Market Monitor przygotowanego przez Yole Intelligence, w latach 2015–2023 cała branża pamięci NAND dostarczyła 3,1 zettabajta (ZB), inwestując przy tym ogromną kwotę 208 mld USD w nakładach kapitałowych, co stanowi równowartość mniej więcej 47% łącznych przychodów.

W przeciwieństwie do tego branża dysków twardych odpowiada za zaspokojenie większości – prawie 90% – potrzeb związanych z pamięcią masową w centrum danych w bardzo kosztowo efektywny sposób. Aby to zilustrować, użyjemy firmy Seagate Technology jako przykładu dla branży dysków twardych. W latach 2015–2023 firma Seagate dostarczyła 3,5 ZB pamięci masowej. Inwestycje kapitałowe firmy Seagate w tym ośmioletnim okresie wyniosły 4,3 mld USD, czyli zaledwie mniej więcej 5% łącznych przychodów Seagate ze sprzedaży dysków twardych. Odpowiada to mniej więcej 67 miliardom USD na ZB w branży pamięci NAND w porównaniu do mniej więcej 1 mld USD na ZB przy produkcji dysków twardych (na przykładzie firmy Seagate). Branża dysków twardych znacznie bardziej efektywnie dostarcza ZB do centrum danych. Przeprowadzona przez Seagate analiza prognoz IDC dla dysków twardych oraz prognozy dla dysków SSD wskazują, że w 2024 roku produkcja EB w ramach dysków twardych będzie prawie trzy razy większa niż w przypadku dysków SSD. W tym samym roku na rynkach rozwiązań dla centrów danych i dla przedsiębiorstw produkcja EB w dyskach twardych będzie sześciokrotnie większa niż w dyskach SSD.

Ostatnio niektórzy dostawcy macierzy AFA twierdzili, że do 2028 roku branża pamięci flash może w pełni zastąpić całą produkcję dysków twardych. Przyjrzyjmy się, jakie inwestycje byłyby potrzebne do osiągnięcia tego celu przez branżę pamięci NAND.

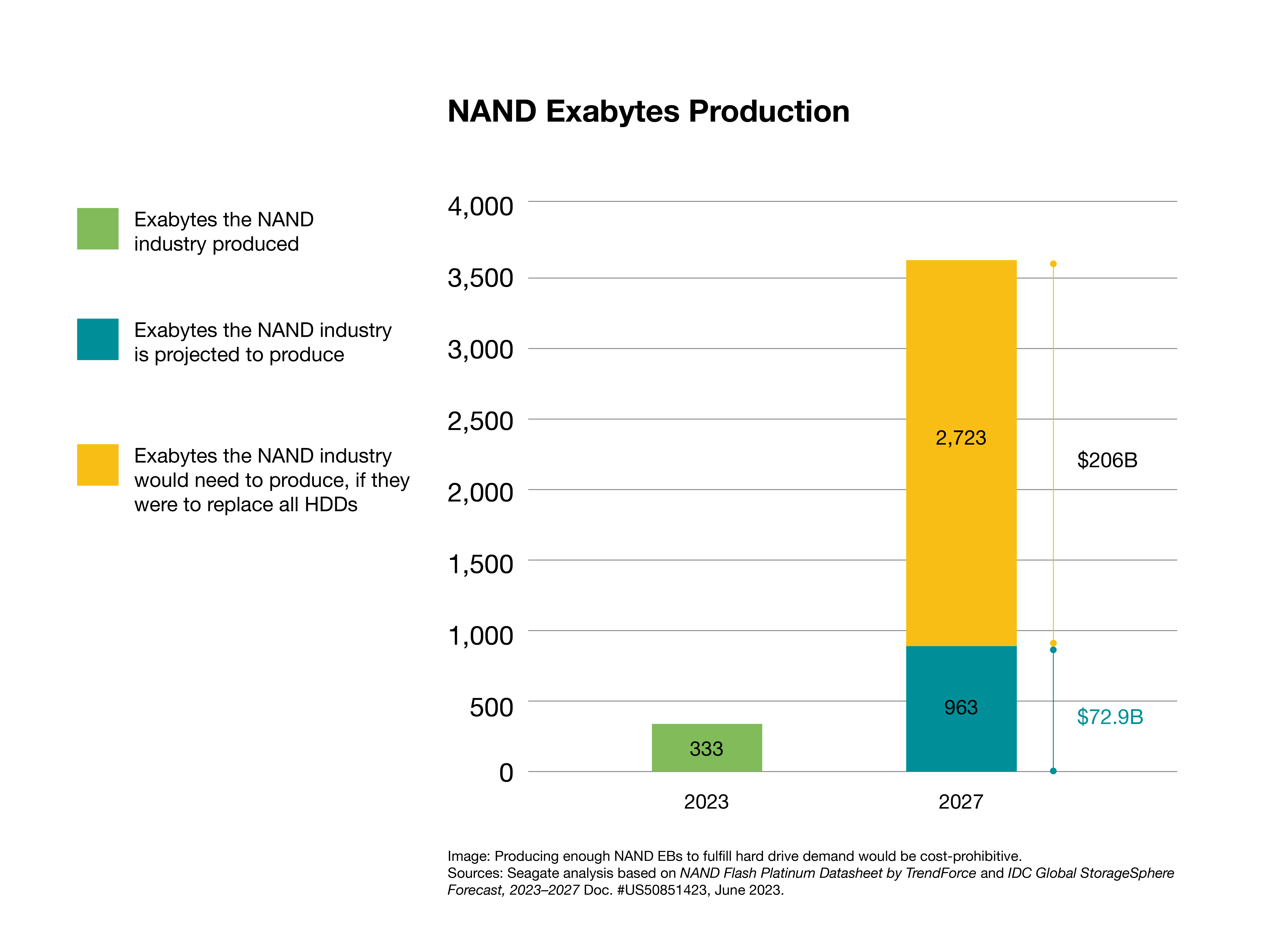

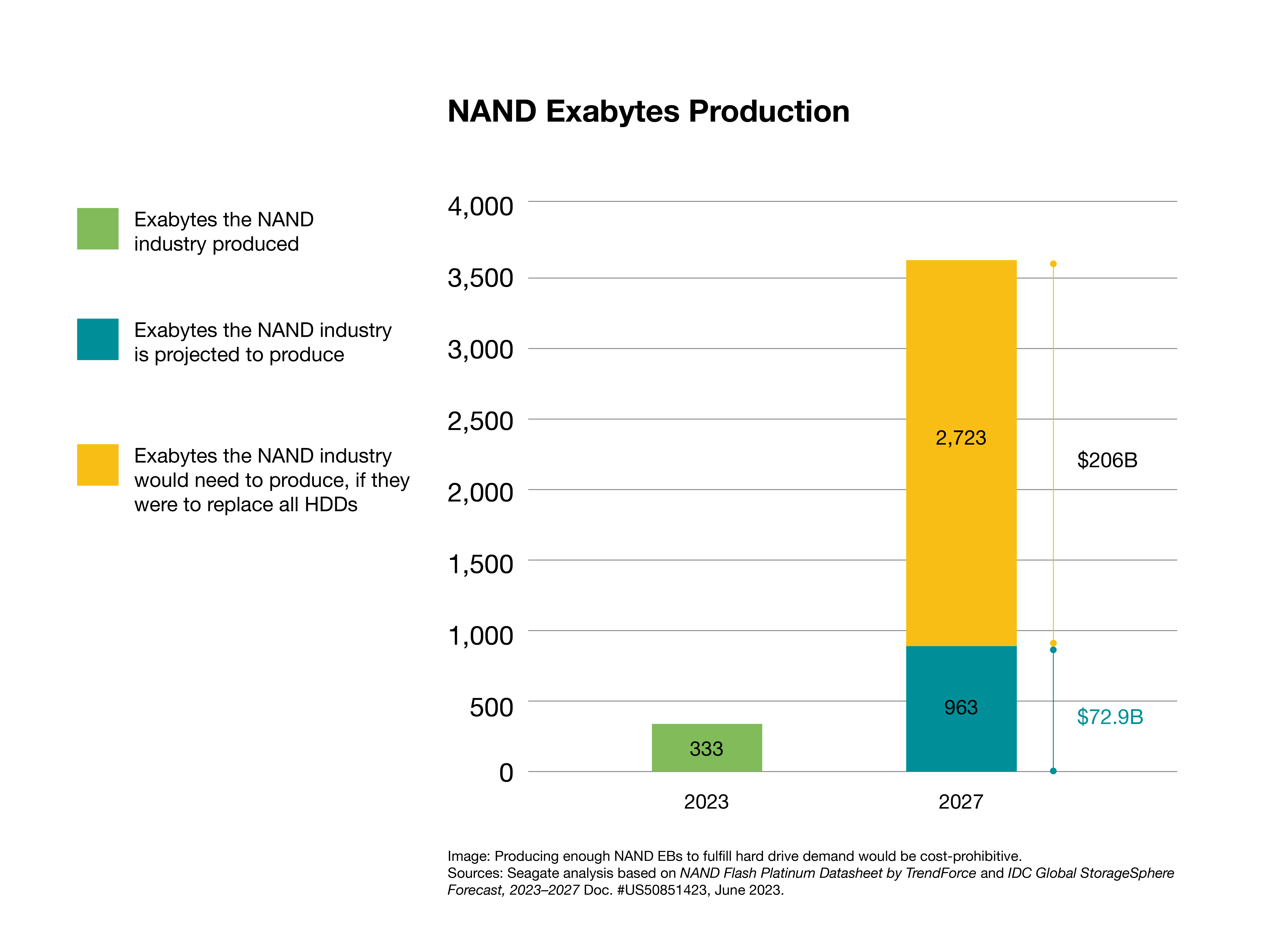

Cytowany powyżej raport Yole Intelligence wskazuje, że od 2025 do 2027 roku branża pamięci NAND zainwestuje mniej więcej 73 mld USD, co, jak się szacuje, oznacza 963 EB na dyskach SSD klasy enterprise, a także innych produktów NAND przeznaczonych do tabletów i telefonów. Przekłada się to na inwestycję około 76 USD na TB pojemności pamięci flash. Stosując tę samą cenę kapitałową na bit, wymagałoby to ogromnej dodatkowej inwestycji w wysokości 206 miliardów USD, aby dorównać pojemności 2,723 ZB dysków twardych przewidzianej na rok 2027. W sumie daje to prawie 279 mld USD inwestycji na łącznym rynku docelowym wynoszącym mniej więcej 25 mld USD.

Oczywiste jest, że taki poziom inwestycji jest mało prawdopodobny w branży stojącej w obliczu niepewnych zwrotów, zwłaszcza po stratach z 2023 roku.

Najnowsze badanie NAND Flash Platinum Datasheet firmy TrendForce pokazuje, że w 2024 roku na całym świecie będzie działać mniej więcej 28 fabryk produkujących pamięć NAND. Biorąc za przykład fabrykę Fab7 Phase 1 firmy Kioxia, otwartą w październiku 2022 roku, budowa od podstaw jednej fabryki pamięci NAND to koszt około 6,8 mld USD. W związku z tym nakłady kapitałowe w wysokości 206 mld USD potrzebne w branży pamięci NAND równałyby się mniej więcej 30 nowym fabrykom. Takie obiekty musiałyby zostać zbudowane, dostosowane pod względem skali, przetestowane, zatwierdzone i wprowadzone do pełnej produkcji w ciągu najbliższych trzech–czterech lat, podwajając liczbę fabryk pamięci NAND na całym świecie w mniej niż cztery lata.

Ponadto raport IDC 2023 StorageSphere2 pokazuje, że w 2023 roku stosunek dysków twardych do pojemności zainstalowanych dysków SSD w centrach danych w chmurze i poza chmurą wynosił 7 do 1. IDC prognozuje, że ten dominujący wskaźnik eksabajtów na dyskach twardych w przewidywalnej przyszłości utrzyma się na 6–7 krotnym poziomie, przy 26% złożonej rocznej stopie wzrostu (CAGR), co w 2027 roku przyniesie pojemność na poziomie 10 ZB zainstalowanych dysków twardych. W związku z tym, oprócz zastąpienia całej przyszłej rocznej produkcji nowo instalowanych dysków twardych rok po roku, jak opisano wcześniej, branża pamięci NAND musiałaby również zainwestować w wymianę starzejącej się części z bazy 10 ZB zainstalowanych dysków twardych w centrach danych, gdy osiągną kres swojego cyklu życia. Taka przyrostowa inwestycja znacznie przekraczałaby kwotę 206 mld USD na zastąpienie 2,723 ZB pojemności dysków twardych, która ma być dostarczona w 2027 roku.

Rozwiązania NAND efektywnie obsługują określone obciążenia robocze w centrach danych, ale pomysł, że centra danych będą w pełni na nich polegać, jest problematyczny. Do ryzyka i niskiego prawdopodobieństwa, że branża pamięci NAND może zastąpić producentów dysków twardych, dochodzi jeszcze niestabilność cenowa, która jest niepożądanym czynnikiem w firmach poszukujących stabilności dostaw i najlepszego całkowitego kosztu posiadania pamięci masowej.

Pomysł, że technologia NAND mogłaby całkowicie zastąpić dyski twarde w dającej się przewidzieć przyszłości, jest mało prawdopodobny, jeśli nie niemożliwy. Branża musiałaby przezwyciężyć ogromne przeszkody finansowe i logistyczne, inwestując jednocześnie duże ilości kapitału i technologii w rynek, który nie jest przygotowany na zmiany, co mogłyby wywrócić obecną architekturę centrum danych.

Prawda nr 3 – Profile obciążeń

Mit: Tylko macierze AFA mogą zaspokoić wymogi wydajnościowe przy obsłudze obciążeń we współczesnych przedsiębiorstwach.

Rzeczywistość: Architektura pamięci masowej w przedsiębiorstwach zwykle łączy różne typy nośników, korzystając z macierzy dyskowych lub hybrydowych, pamięci flash i taśm do optymalizacji pod kątem kosztów, pojemności i wydajności przy obsłudze określonych obciążeń roboczych.

Fałszywa dychotomia przeszkadza w takim podejściu. Dostawcy rozwiązań all-flash zalecają „uproszczenie” rozwiązań i „zabezpieczenie ich przed przyszłymi wyzwaniami” przez stosowanie wyłącznie wysokowydajnej pamięci flash. W innym wypadku, jak informują, przedsiębiorstwa ryzykują utratę możliwości nadążania za wymaganiami w zakresie wydajności, wiążącymi się ze współczesnymi obciążeniami roboczymi. Ta logika o sumie zerowej jest błędna z trzech powodów:

- Zdecydowana większość obecnych obciążeń roboczych nie wymaga wysokowydajnej obsługi oferowanej przez pamięć flash.

- Przedsiębiorstwa z ograniczonym budżetem i szybko rosnącymi zestawami danych muszą odpowiednio zbilansować pojemność i koszty z wydajnością.

- Rzekoma prostota architektury jednowarstwowej pamięci masowej tworzy więcej problemów niż rozwiązań.

Przyjrzyjmy się im po kolei.

Po pierwsze, większość danych na świecie znajduje się w chmurze i dużych centrach danych. W takich środowiskach obciążenia podlegają zasadzie Pareta: tylko niewielki procent obciążenia wymaga dużego odsetka wydajności do przetworzenia. To dlatego, według danych IDC3, w ciągu ostatnich pięciu lat niemal 90% zainstalowanej pamięci masowej u dostawców usług w chmurze oraz w hiperskalowych centrach danych było obsługiwane przez dyski twarde.

Spójrzmy na poniższy wykres, zaczerpnięty z badania IDC Global DataSphere z 2023 r. Większość danych na świecie wchodzi w skład obciążeń roboczych wymagających nominalnego czasu transferu danych do ogólnych zastosowań.

W niektórych przypadkach systemy all-flash nie są w ogóle wymagane jako część rozwiązań o najwyższej wydajności. Istnieją hybrydowe systemy pamięci masowej, które działają tak samo lub szybciej niż systemy all-flash. Na poziomie urządzenia różnice w wydajności są oczywiste; ale w szafach centrum danych dysk twardy zyskuje na wydajności dzięki wyjątkowo równoległemu dostępowi, co skutkuje poprawą wydajności, która jest więcej niż wystarczająca do obsługi większości obciążeń roboczych, w tym sztucznej inteligencji i uczenia maszynowego. Równie ważne jest to, że istotne korzyści w zakresie wydajności oferowane przez pamięć flash mogą być ograniczone innymi decyzjami infrastrukturalnymi, jak na przykład pojemność lub jakość sieci.

Po drugie, jak ustalono wcześniej w tym artykule, rozważania na temat całkowitego kosztu posiadania są kluczem do podejmowania większości decyzji dotyczących infrastruktury centrum danych. Wymusza to zachowanie równowagi pomiędzy kosztami, pojemnością a wydajnością. Optymalny całkowity koszt posiadania jest osiągany przez dostosowanie najbardziej opłacalnego nośnika – dysku twardego, pamięci flash lub taśmy – do danego obciążenia. Dyski twarde i macierze hybrydowe (zbudowane z dysków twardych i dysków SSD) doskonale sprawdzają się w większości pamięci masowych w przedsiębiorstwach i w chmurze oraz aplikacjach.

Można, oczywiście, zdecydować się na użycie dysków SSD lub AFA do obciążeń, do obsługi których najlepiej pasują dyski twarde, takich jak usługi w zakresie plików, obiektowa pamięć masowa, systemy zarządzania dokumentami lub hosting sieciowy. Jednak z punktu widzenia kosztów, im większa pojemność, tym bardziej nielogiczna byłaby taka decyzja. To tak, jakby przechować ubrania w samochodzie zaparkowanym w garażu. Można to robić? Oczywiście, jeśli właśnie do tego chcesz wykorzystywać swój samochód. Ale czy to opłacalne? Nie.

Choć pamięć masowa typu flash doskonale sprawdza się w scenariuszach o dużej intensywności odczytu, jej wytrzymałość zmniejsza się wraz ze wzrostem aktywności związanej z zapisem. Producenci rozwiązują ten problem, stosując korekcję błędów i przewymiarowanie zasobów – dodatkową, niewidoczną pamięć masową w celu zastąpienia zużytych komórek. Te rozwiązania wiążą się jednak z dodatkowymi kosztami: Overprovisioning znacznie zwiększa koszt produktu i wymaga stałego zasilania, aby uniknąć utraty danych. Jest to wyzwanie dla środowisk, takich jak centra danych na brzegu sieci lub w innych miejscach, gdzie ciągłość działania nie jest gwarantowana, a w wysokich temperaturach następuje akceleracja.

Ponadto o ile dzięki technologiom TLC i QLC dyski flash mogą obsługiwać obciążenia robocze o dużej intensywności danych podobnie jak dyski twarde, to przy większych zestawach danych lub długookresowym przechowywaniu opłacalność ekonomiczna takiego rozwiązania słabnie. W takich sytuacjach napędy dyskowe są bardziej kosztowo efektywnym rozwiązaniem ze względu na swoją rosnącą gęstość powierzchniową. W środowiskach hiperskalowych równoległe wykorzystanie tysięcy dysków twardych pozwala osiągnąć wydajność, która jest uzupełnieniem pamięci flash, co doskonale ilustruje współpracę w nowoczesnych centrach danych.

W związku z tym, chociaż pamięć QLC flash przejmuje znaczną część rynku TLC – podobnie jak wcześniej TLC zastąpiła pamięć wielopoziomową (MLC) NAND – nie wpływa to jednak na zmniejszenie udziału dysków twardych w rynku ze względu na koszty, dostępność i względy związane z obciążeniami, które zostały omówione w tym artykule.

Trzecim, i nawiązującym do powyższego, jest twierdzenie, że dyski AFA przewyższają macierze hybrydowe i systemy pamięci masowej oparte na dyskach twardych. Zwolennicy pamięci flash twierdzą, że korzystanie z jednego typu pamięci masowej jest „prostsze” niż łączenie różnych typów nośników i warstw pamięci. Nie tak szybko.

Wiele hybrydowych systemów pamięci masowej wykorzystuje sprawdzoną i dopracowaną architekturę definiowaną programowo, która płynnie integruje i wykorzystuje zalety różnych typów nośników w jednej całości. W skalowalnych architekturach prywatnych lub publicznych centrów danych w chmurze systemy plików lub pamięć masowa definiowana programowo są wykorzystywane do zarządzania pamięcią masową centrów danych w różnych lokalizacjach i regionach. Elastyczność, którą oferują, aż nadto wystarcza, aby umożliwić firmom dostosowanie struktury swojej pamięci masowej do stale zmieniających się potrzeb.

Macierze AFA i dyski SSD doskonale nadają się do obsługi obciążeń roboczych wymagających wysokiej wydajności, przy dużej liczbie operacji odczytu. Błędem jest jednak przenoszenie niszowych zastosowań czy instalacji obliczonych na małą skalę na rynek masowy i do hiperskali, gdzie macierze AFA stanowią niepotrzebnie kosztowną metodę osiągnięcia tego, co dyski twarde już dostarczają przy znacznie niższym całkowitym koszcie posiadania.

Architektury pamięci masowej w chmurze, hiperskali i do dużych zastosowań korporacyjnych korzystają z pamięci masowej, która optymalizuje koszty, pojemność i wydajność. Dyski twarde obsługują obciążenia, które nie powinny być obsługiwane przez pamięć flash. Pamięć flash obsługuje obciążenia, które nie powinny być obsługiwane przez dyski twarde. Oba nośniki pamięci masowej będą współistnieć w centrum danych, zaś dyski twarde będą w dającej się przewidzieć perspektywie nadal dominować pod względem ilości przechowywanych eksabajtów (EB).

Architektury pamięci masowej w chmurze, hiperskali i do dużych zastosowań korporacyjnych korzystają z pamięci masowej, która optymalizuje koszty, pojemność i wydajność. Dyski twarde obsługują obciążenia, które nie powinny być obsługiwane przez pamięć flash. Pamięć flash obsługuje obciążenia, które nie powinny być obsługiwane przez dyski twarde. Oba nośniki pamięci masowej będą współistnieć w centrum danych, zaś dyski twarde będą w dającej się przewidzieć perspektywie nadal dominować pod względem ilości przechowywanych eksabajtów (EB).

Mówiąc o EB, często wskazuje się na rosnącą liczbę dysków SSD w kontekście mniejszej produkcji dysków twardych, co ma być dowodem, że nastąpił punkt zwrotny na rynku pamięci masowej. Ale ten argument to fałszywy trop, ponieważ nie uwzględnia postępów w zakresie pojemności i całkowitych eksabajtów wyprodukowanych dysków twardych, które wykazują dynamiczną tendencję wzrostową. A konkretnie, dzięki osiągniętym za sprawą technologii HAMR innowacjom w zakresie gęstości powierzchniowej nowa platforma Mozaic™ firmy Seagate podwoi w ciągu następnych czterech lat maksymalną pojemność urządzenia, podczas gdy tradycyjna technologia magnetycznego zapisu prostopadłego (PMR) potrzebowała dziewięciu lat na podwojenie pojemności.

Zamiast ilości dysków, tym, co ma znaczenie dla dokładnego pomiaru rozwoju, są dostarczane eksabajty. Analitycy przewidują, że dostawy eksabajtów na dyskach twardych będą nadal rosnąć w bezprecedensowym tempie. I choć pamięć flash również stale się rozwija, to daleko jej do dysków twardych pod względem zainstalowanej pojemności.

Przeprowadzona przez Seagate analiza danych IDC oraz TRENDFOCUS przewiduje do 2028 roku zwiększenie EB na dyskach twardych o prawie 250%. Dokonując ekstrapolacji w dłuższej perspektywie, współczynnik ten utrzyma się także w następnej dekadzie. Spójrzmy:

Wniosek – dyski twarde zostaną z nami na długo

Rzekomy zmierzch technologii dysków twardych jest tematem dyskusji w branży technologicznej od ponad dekady. Jednak te prognozy nie potwierdziły się. Nie spodziewamy się również, żeby teraz miało się coś zmienić pod tym względem.

Prawie zawsze absolutyści uznający tylko technologię all-flash próbują uzasadnić swoje racje, stosując błędne rozumowanie, często ekstrapolują niewielką liczbę przypadków użycia, próbując przenieść je do większego kontekstu, co powoduje, że ich wnioski nie są uzasadnione.

To w najlepszym razie kreatywny marketing.

W rzeczywistości:

- Ceny dysków twardych i pamięci NAND nie zbliżą się w najbliższym czasie do siebie, zwłaszcza kiedy mamy do czynienia z przyspieszonym wzrostem gęstości powierzchniowej dysków twardych, jaką zapewnia platforma Mozaic 3+ firmy Seagate.

- W przeciwieństwie do tego, co niektórzy sugerują, producenci pamięci NAND nie będą w stanie zwiększać mocy produkcyjnych i zastąpić zapotrzebowanie na eksabajty dostarczane przez istniejące i nowe dyski twarde. Producenci macierzy AFA nie są w stanie zaoferować jednocześnie wystarczającej podaży pamięci masowej tańszej niż dyski twarde ze względu na poziom wymaganych inwestycji. Jest mało prawdopodobne, że producenci macierzy AFA znajdą setki miliardów dolarów na inwestycje z perspektywą strat 10 do 1, aby wyprodukować pamięć NAND w ilości wystarczającej do zastąpienia dysków twardych.

- Operatorzy dużych chmur i centrów danych klasy korporacyjnej są pragmatyczni i rozumieją, że skalowalna architektura pamięci masowej wymaga połączenia różnych nośników – zoptymalizowanych pod kątem budżetu, pojemności i wydajności oraz określonych obciążeń roboczych.

Oczywiście istnieją inne mity przyczyniające się do „kreatywnego marketingu”, który zapowiada upadek dysków twardych – mity dotyczące zrównoważonego rozwoju, zasilania, niezawodności i innych obszarów. Zajmiemy się nimi w kolejnych postach. Trzy mity omówione powyżej uważamy jednak za najbardziej rozpowszechnione.

Poważna analiza danych przedstawionych w tym artykule musi prowadzić do wniosku, że dyski twarde zostaną z nami na długo. W przyszłości będzie na nich nadal przechowywana większość danych na świecie.

Sugerowanie czegoś innego jest czystym zwodzeniem.

To nie jest gra o sumie zerowej. W centrach danych dyski twarde i pamięć flash zawsze pracowały w synergii i były instalowane do obsługi różnych usług. Oba typy pamięci mają swoje unikatowe zalety i propozycje wartości. W rzeczywistości w erze generatywnej sztucznej inteligencji klastry komputerowe ściśle powiązane z pamięcią flash pośrednio generują zapotrzebowanie na więcej eksabajtów na dyskach twardych, ponieważ tworzone treści muszą być przechowywane w ekonomiczny sposób.

To nie jest gra o sumie zerowej. W centrach danych dyski twarde i pamięć flash zawsze pracowały w synergii i były instalowane do obsługi różnych usług. Oba typy pamięci mają swoje unikatowe zalety i propozycje wartości. W rzeczywistości w erze generatywnej sztucznej inteligencji klastry komputerowe ściśle powiązane z pamięcią flash pośrednio generują zapotrzebowanie na więcej eksabajtów na dyskach twardych, ponieważ tworzone treści muszą być przechowywane w ekonomiczny sposób.

Architektury pamięci masowej w chmurze, hiperskali i do dużych zastosowań korporacyjnych korzystają z pamięci masowej, która optymalizuje koszty, pojemność i wydajność. Dyski twarde obsługują obciążenia, które nie powinny być obsługiwane przez pamięć flash. Pamięć flash obsługuje obciążenia, które nie powinny być obsługiwane przez dyski twarde. Oba nośniki pamięci masowej będą współistnieć w centrum danych, zaś dyski twarde będą w dającej się przewidzieć perspektywie nadal dominować pod względem ilości przechowywanych eksabajtów (EB).

Architektury pamięci masowej w chmurze, hiperskali i do dużych zastosowań korporacyjnych korzystają z pamięci masowej, która optymalizuje koszty, pojemność i wydajność. Dyski twarde obsługują obciążenia, które nie powinny być obsługiwane przez pamięć flash. Pamięć flash obsługuje obciążenia, które nie powinny być obsługiwane przez dyski twarde. Oba nośniki pamięci masowej będą współistnieć w centrum danych, zaś dyski twarde będą w dającej się przewidzieć perspektywie nadal dominować pod względem ilości przechowywanych eksabajtów (EB).