人工智慧 (AI) 和機器學習 (ML) 推動了革命性的突破,從預測蛋白質結構到實現即時語言翻譯。不斷追求創新的核心,是因為我們希望高品質的資料能更臻完美。AI 模型在龐大的資料集上茁壯成長,但如果沒有可靠且經濟實惠的資料儲存裝置,這些模型及其產生的深度分析將無法發揮其潛力。

就像氧氣能促進人類思維,資料儲存同樣能促進 AI 的發展。有效儲存、存取和處理資料的能力,關乎 AI 模型的訓練和精煉效果如何。然而隨著對 AI 驅動型解決方案的需求不斷成長,如何管理 AI 資料的生命週期 (從收集到儲存再到處理) 的挑戰也隨之上升, 同時還要控制成本和復雜性。

對 AI 就緒資料的需求不斷成長

資料科學已經從電子表格和簡單的分析發展為強大的機器學習驅動型深度分析。根據美國勞工部的報告,目前有超過 200,000 個資料科學的工作,未來十年預計成長 36%。各行各業的領域專家都在將 AI 工具納入工作流程中,即使沒有經過正式的資料科學訓練,也能使用無程式碼平台用更勝以往的速度建置模型和分析資料。

但原始資料本身並無法產生用途。在將資料輸入 AI 模型之前,必須先將資料結構化、清理和標記,這個過程通常稱為資料整理。開放原始碼工具例如 Pandas 協助將大量資料集轉換為 AI 模型可使用的結構化格式。不過此程序需要快速、高效的本機資料儲存裝置才能避免出現拖慢模型開發速度的瓶頸。

AI 資料管理的挑戰

龐大的 AI 訓練資料量使得後勤管理面臨嚴峻的挑戰。大型資料集的儲存和管理不只是容量的問題,還關係到成本、合規性和存取性。

AI 資料管理的最大挑戰包括:

- 資料主權與安全性。組織必須遵守有關智慧財產權、隱私權和司法管轄權的法規。

- 雲端儲存成本。將 AI 資料集儲存在雲端上,可能比使用內部部署 NAS 解決方案要貴上 5 到 10 倍。

- 資料移動瓶頸。跨廣域網路傳輸大型資料集既緩慢又昂貴,對地理位置分散的團隊造成延遲。

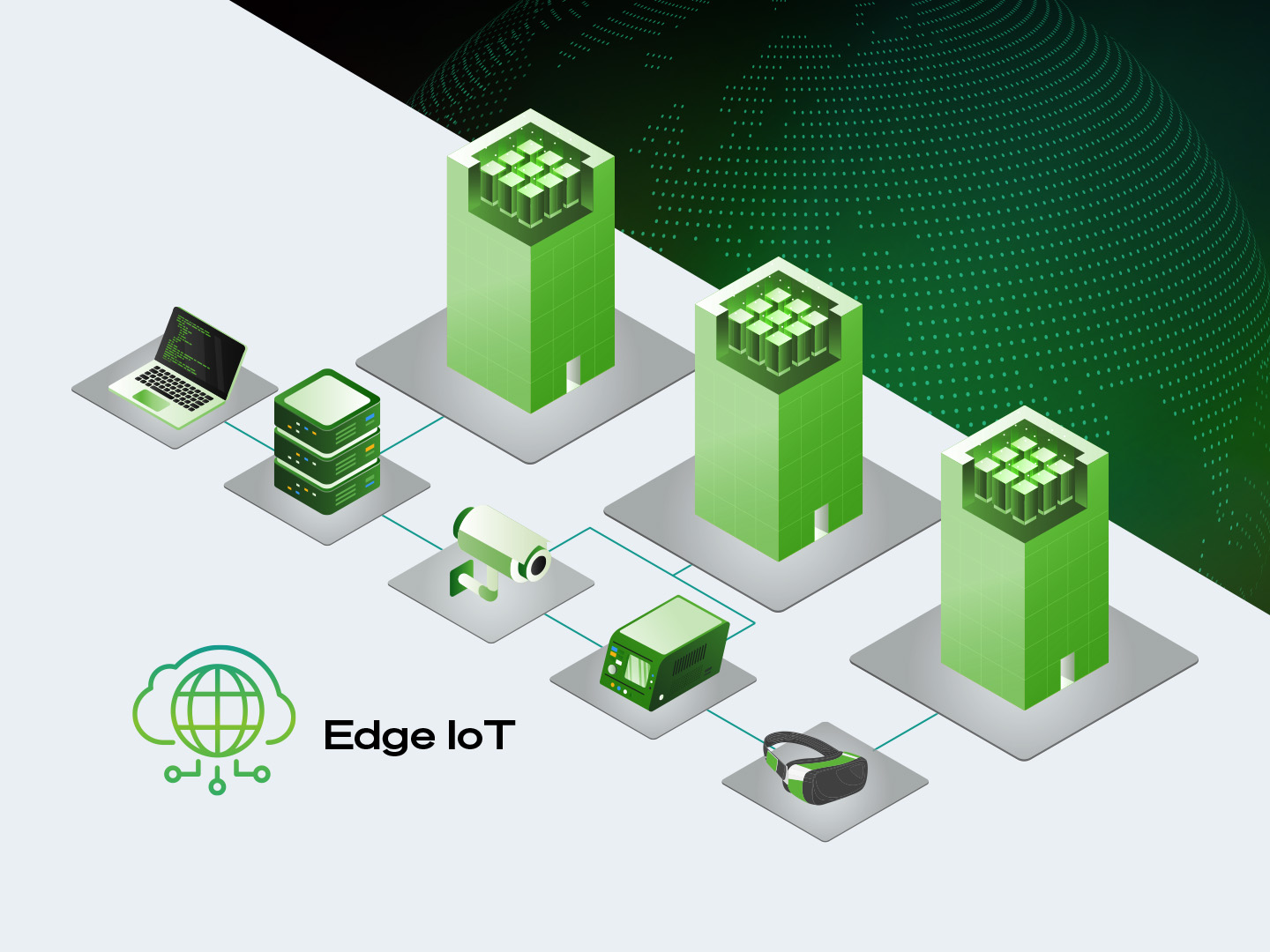

來自地理位置分散的資料,對傳統的集中式儲存方法帶來挑戰。愈來愈多 AI 從業者轉向使用本地邊緣儲存解決方案,能更加掌握、降低成本和降低延遲。

將 AI 資料儲存裝置帶到邊緣

與其將龐大的資料集傳輸到集中式雲端伺服器,企業組織不妨將處理和儲存 AI 資料的位置,移到更貼近資料產生之處。這種方法 (通常稱為邊緣運算) 可將資料移動成本降至最低,同時提升效能。

其中一種經濟實惠的解決方案是小型混合式 NAS 系統,可為 AI 工作負載提供本機的高效能儲存裝置。與傳統 NAS 不同的是,這類系統整合了容器化的 AI 工具 (例如 Jupyter Notebook),讓領域專家和 AI 開發人員能夠直接在儲存系統上進行協同合作。這些 NAS 解決方案無需持續傳輸資料,可降低營運成本同時加速 AI 開發。

在邊緣處理 AI 資料也能讓企業組織更有效地控制資料集。維護 AI 訓練資料的自主權可確保符合業界法規並降低與第三方儲存裝置相關的風險。將資料保存在靠近資料收集和分析位置的方法可提高 AI 工作流程的效率。

邊緣運算能為 AI 開發提供多種優勢:

- 成本更低。減少雲端儲存和資料傳輸費用。

- 加快 AI 開發速度。將訓練資料保留在本機以便快速存取。

- 更佳的資料控制能力。確保資料在內部儲存和處理以維護主權和合規性。

AI 邊緣實驗室系統架構和設定

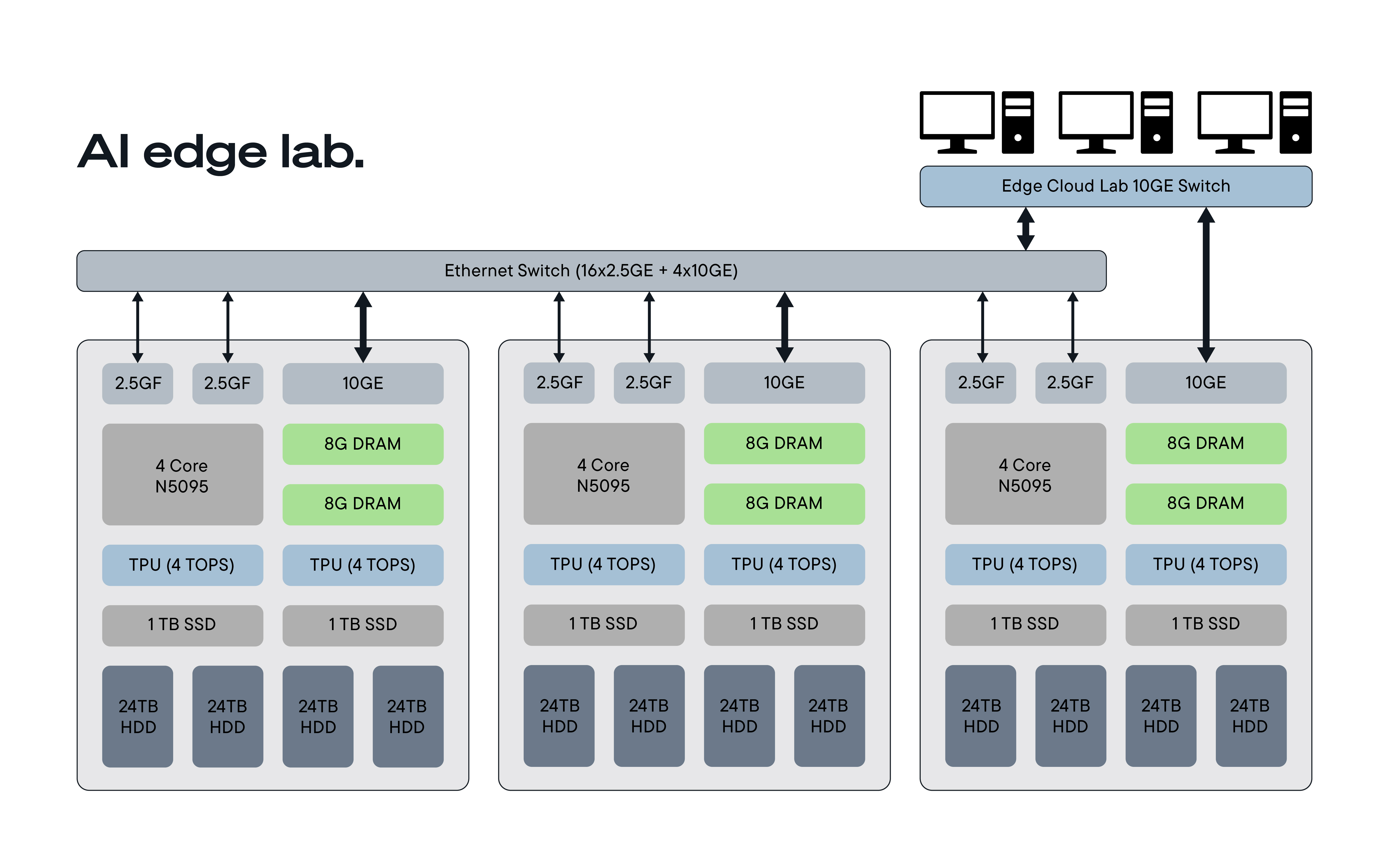

為了探索在本地儲存裝置上執行 AI 工作負載的可行性,我們建置了三節點 NAS 叢集並測量其儲存效能。

系統配置:

- 硬體:

- Intel N5095 處理器 (低功耗)

- 雙 2.5GE 乙太網路連接埠

- 4 x 24TB IronWolf® Pro 硬碟機 (RAID5 每節點可使用 70TB)

- 選配 SSD 和張量處理單元 (TPU) 全面加速

- 軟體:

- 適用於 Python 型 AI 開發的 Jupyter Notebook 容器

- NATS Jetstream 提供容錯訊息傳送、鍵值儲存和物件儲存

- 多節點資料複製可提供備援和彈性

性能測試:評估儲存和網路

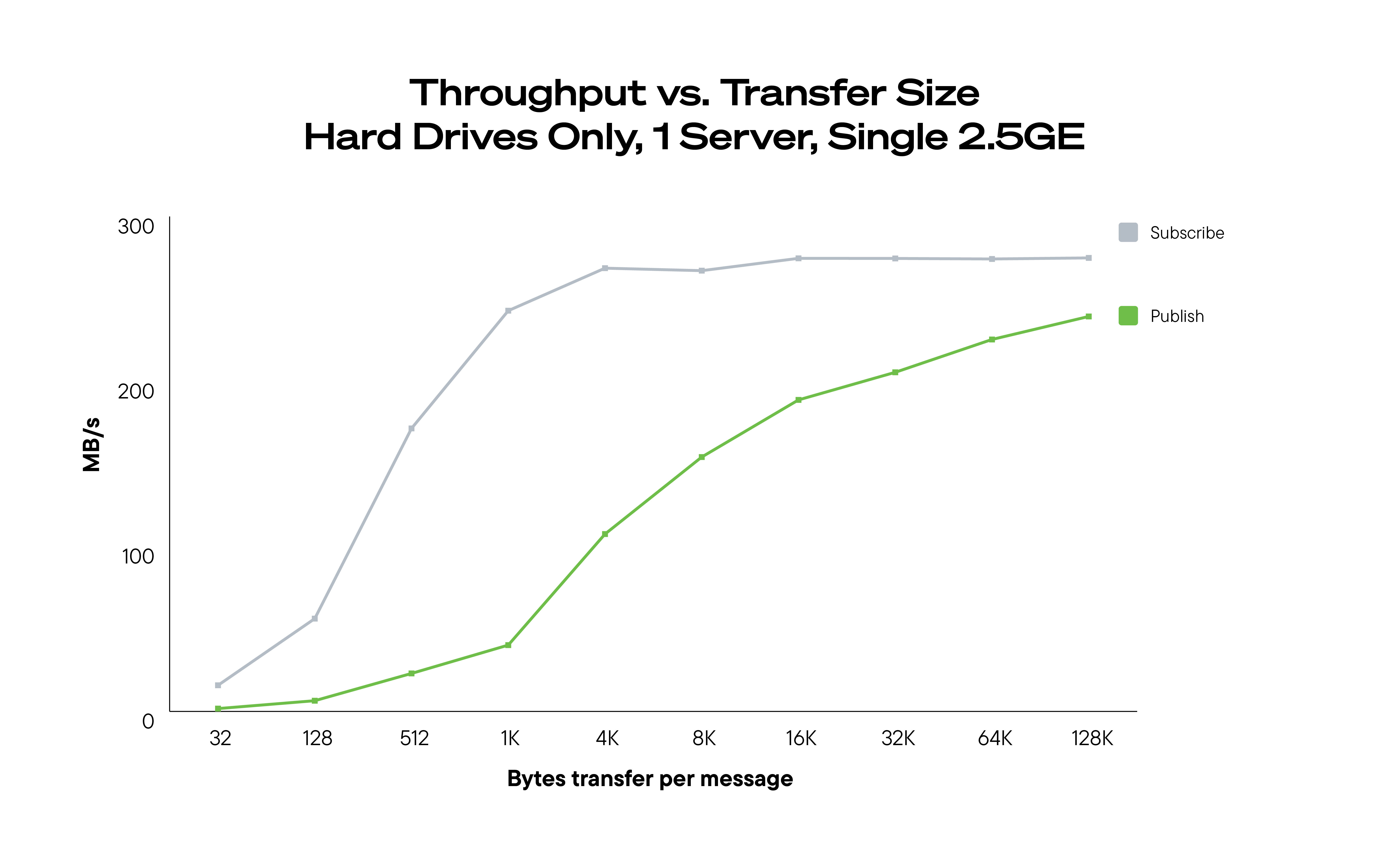

我們首先測量單節點效能作為建立傳輸量的基準。該系統達到每 2.5GE 連結 200MB/秒,適合用於大量資料傳輸。

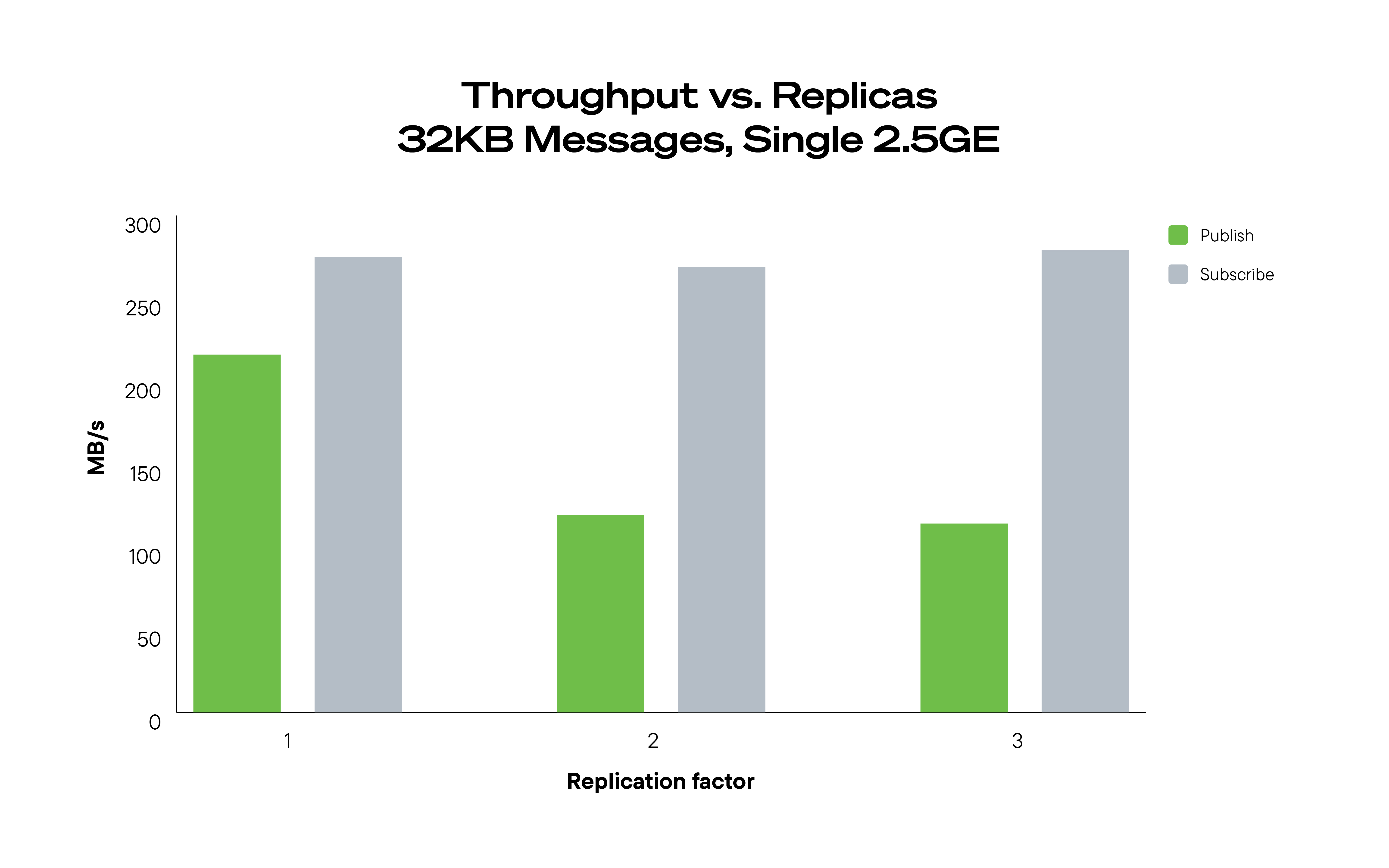

接著我們分析了多節點複寫對效能的影響。雖然資料複製增加了網路流量,對讀取效能的影響微乎其微,對於需要跨多個節點的資料一致性的工作負載來說這是一項關鍵優勢。

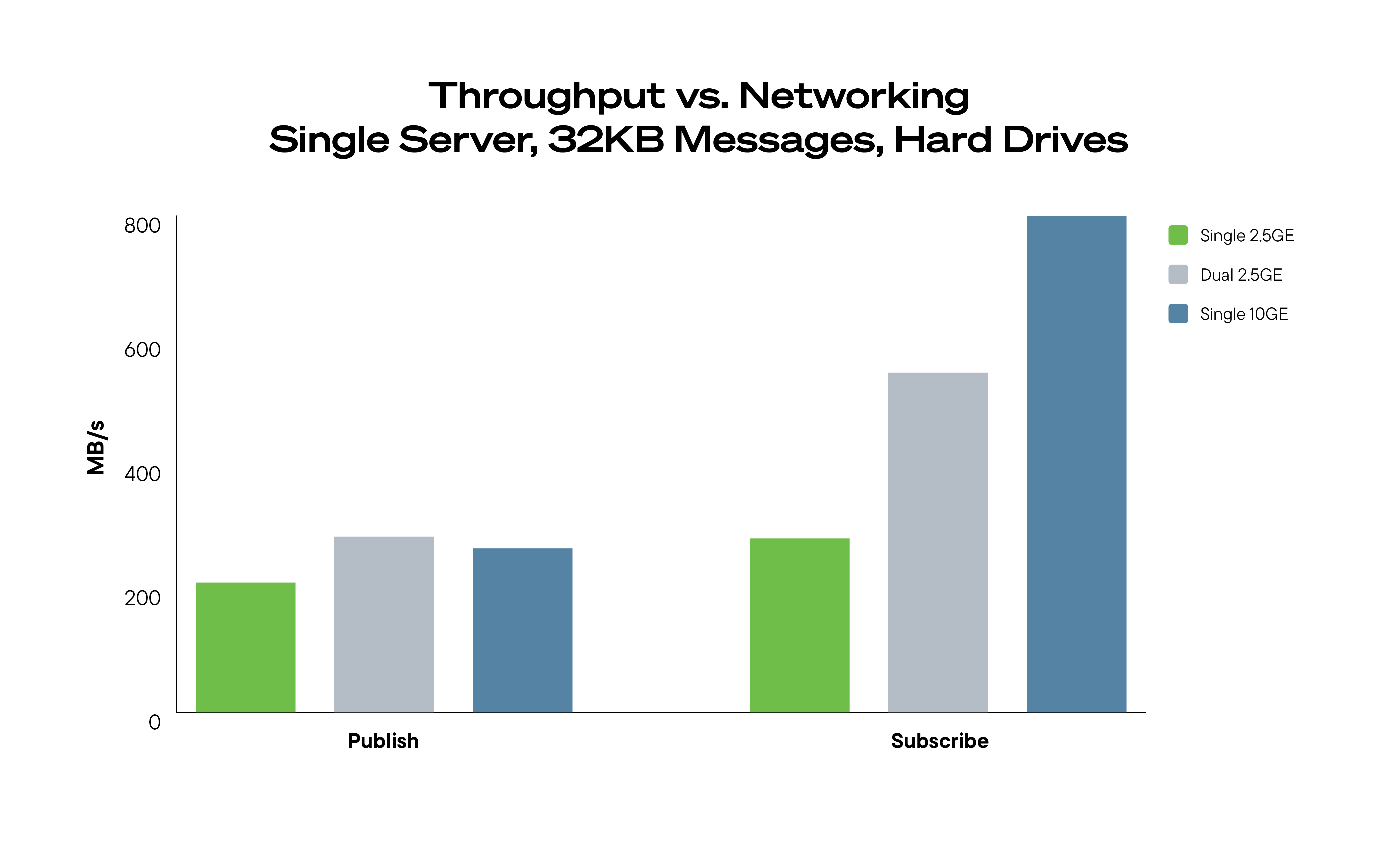

網路效能測試顯示新增第二個 2.5GE 連結僅能提供較小的寫入優勢,而 10GE 網路在特定情況下可改善效能。

邊緣的真實 AI 訓練

為了模擬 AI 工作流程,我們使用 NAS 系統測試了真實的機器學習任務。我們使用包含 500 個標記影像的資料集訓練船隻分類模型,並在本機執行特徵擷取和模型訓練。

在使用中繼資料標籤將影像儲存在物件儲存貯體中之後,我們使用 PyTorch Img2Vec 從每張影像中擷取特徵,然後訓練隨機森林分類器。最終模型在不到一分鐘內達到了 78% 的準確度。

此測試的主要觀察結果包含:

- 特徵擷取花費的時間最多 (81%),需要加快本機儲存。

- AI 模型訓練可在不到一分鐘的時間完成,證明 AI 工作流程對本機 NAS 效率。

- 未經過正式 AI 訓練的領域專家能成功執行實驗,證明此方法的可存取性。

這項實驗顯示本機 NAS 儲存裝置可做為經濟實惠的 AI 資料中樞,減少對雲端服務的依賴,同時改善存取性和效能。

概念總結:AI 儲存裝置必須進化

AI 的未來仰賴高效率、經濟實惠且易於擴充的資料儲存裝置。隨著資料量持續成長,企業組織必須重新思考儲存和管理 AI 資料集的方式。

本機 NAS 解決方案為昂貴的雲端儲存提供實用的替代方案,讓 AI 團隊能夠

- 降低成本的同時維持高效能的資料存取能力。

- 透過讓資料靠近運算的方式提升 AI 工作流程效率。

- 藉由控制 AI 資料所在的位置提升合規性和自主權。

就如同氧氣能延續生命,資料儲存裝置也能延續 AI 創新。透過讓 AI 就緒的儲存裝置更易於存取、更具成本效益和高效能,加速企業組織突破 AI 驅動的速度。